Миграция PROXMOX VE 3.0 в software RAID1

В данном материале описывается процесс миграции свежеустановленного гипервизора Proxmox 3.0 в программный RAID1. Разработчики Proxmox в своей wiki пишут о том, что данное решение официально не поддерживается и не рекомендуется к использованию. Взамен этого предлагается использовать решения на протестированных аппаратных raid-контроллерах.

Тем не менее в сети можно найти несколько мануалов по этой теме и практики успешной эксплуатации softraid'а совместно с Proxmox'ом. К сожалению, большинство этих мануалов нельзя назвать пошаговыми руководствами к действию: все они содержат те или иные ошибки, которые мешают достигнуть требуемого результата.

Взяв за основу один из таких мануалов, я попытался исправить эту ситуацию. Приведённое ниже решение несколько раз было по шагам протестировано сначала в виртуалке, а затем использовано для миграции данных на реальном железе. В результате этого получился рабочий how-to, который предлагается вашему вниманию. Кому интересно, добро пожаловать под cut.

Перед началом миграции у нас имеется следующее:

- Сервер с двумя HDD одинаковой емкости (/dev/sda и /dev/sdb). Диски не в RAID'e.

- Proxmox 3.0 установлен с нуля на первый HDD (/dev/sda)

- В системе установлены все последние обновления (aptitude update && aptitude upgrade)

По окончании миграции оба HDD будут объединены в Soft RAID1, при этом мы сохраним данные, которые были на диске до начала миграции.

Миграция будет происходить в несколько этапов: 0. Установка необходимого ПО. 1. Подготовка дисков к переводу в RAID1. 2. Перенос /boot на /dev/md0. 3. Модификация /etc/fstab. 4. Модификация Grub2.

5. Перенос LVM на /dev/md1, перевод исходного диска в RAID1.

0. Установка необходимого ПО

Ставим mdadm и screen. При установке mdadm спросит, какие модули нужно включить при загрузке. Отвечаем «all». Screen ставить не обязательно, но он поможет нам подстраховаться на 5-м этапе, когда мы будем переносить LVM.

root@kvm0:~# apt-get update

root@kvm0:~# aptitude install mdadm screen

1. Подготовка дисков к переводу в RAID1

Копируем разметку диска sda на sdb. Здесь и далее я привожу полный вывод команд, чтобы на каждом шаге можно было свериться с результатом.

root@kvm0:~# sfdisk -d /dev/sda | sfdisk -f /dev/sdb

Checking that no-one is using this disk right now …

OK Disk /dev/sdb: 4177 cylinders, 255 heads, 63 sectors/track sfdisk: ERROR: sector 0 does not have an msdos signature /dev/sdb: unrecognized partition table type

Old situation:

No partitions found

New situation:

Units = sectors of 512 bytes, counting from 0 Device Boot Start End #sectors Id System

/dev/sdb1 * 2048 1048575 1046528 83 Linux

/dev/sdb2 1048576 67108863 66060288 8e Linux LVM

/dev/sdb3 0 – 0 0 Empty

/dev/sdb4 0 – 0 0 Empty

Warning: partition 1 does not end at a cylinder boundary

Warning: partition 2 does not start at a cylinder boundary

Warning: partition 2 does not end at a cylinder boundary

Successfully wrote the new partition table Re-reading the partition table … If you created or changed a DOS partition, /dev/foo7, say, then use dd(1)

to zero the first 512 bytes: dd if=/dev/zero of=/dev/foo7 bs=512 count=1

(See fdisk(8).)

Помечаем разделы диска sdb, как «Linux raid auto».

root@kvm0:~# sfdisk -c /dev/sdb 1 fd

Done

root@kvm0:~# sfdisk -c /dev/sdb 2 fd

Done

Чтобы убедиться, что на диске нет информации о ранее созданных RAID-массивах, делаем следующее.

root@kvm0:~# mdadm –zero-superblock /dev/sdb1

mdadm: Unrecognised md component device – /dev/sdb1

root@kvm0:~# mdadm –zero-superblock /dev/sdb2

mdadm: Unrecognised md component device – /dev/sdb2

Если диск чист, то видим вышеприведённые сообщения. В противном случае вывод команды будет пустой.

Создаем RAID-массив.

root@kvm0:~# mdadm –create -l 1 -n 2 /dev/md0 missing /dev/sdb1 –metadata=1.1

mdadm: array /dev/md0 started.

root@kvm0:~# mdadm –create -l 1 -n 2 /dev/md1 missing /dev/sdb2 –metadata=1.1

mdadm: array /dev/md1 started.

Добавляем информацию о массиве в mdadm.conf

root@kvm0:~# cp /etc/mdadm/mdadm.conf /etc/mdadm/mdadm.conf_orig

root@kvm0:~# mdadm –examine –scan >> /etc/mdadm/mdadm.conf

2. Перенос /boot на /dev/md0

Создаём файловую систему на /dev/md0. Монтируем её в /mnt/md0 и копируем туда содержимое /boot.

root@kvm0:~# mkfs.ext3 /dev/md0

mke2fs 1.42.5 (29-Jul-2012)

Filesystem label=

OS type: Linux

Block size=1024 (log=0)

Fragment size=1024 (log=0)

Stride=0 blocks, Stripe width=0 blocks

131072 inodes, 522944 blocks

26147 blocks (5.00%) reserved for the super user

First data block=1

Maximum filesystem blocks=67633152

64 block groups

8192 blocks per group, 8192 fragments per group

2048 inodes per group

Superblock backups stored on blocks: 8193, 24577, 40961, 57345, 73729, 204801, 221185, 401409 Allocating group tables: done Writing inode tables: done Creating journal (8192 blocks): done

Writing superblocks and filesystem accounting information: done

root@kvm0:~# mkdir /mnt/md0

root@kvm0:~# mount /dev/md0 /mnt/md0

root@kvm0:~# cp -ax /boot/* /mnt/md0

3. Модификация /etc/fstab

Комментируем в /etc/fstab монтирование boot-раздела через UUID и прописываем монтирование раздела через /dev/md0.

root@kvm0:~# sed -i 's/^UUID/#UUID/' /etc/fstab

root@kvm0:~# echo '/dev/md0 /boot ext3 defaults 0 1' >> /etc/fstab

В итоге /etc/fstab должен выглядеть так.

root@kvm0:~# cat /etc/fstab

#

/dev/pve/root / ext3 errors=remount-ro 0 1

/dev/pve/data /var/lib/vz ext3 defaults 0 1

#UUID=eb531a48-dea8-4356-9b56-8aa800f14d68 /boot ext3 defaults 0 1

/dev/pve/swap none swap sw 0 0

proc /proc proc defaults 0 0

/dev/md0 /boot ext3 defaults 0 1

Перезагружаемся!

4. Модификация Grub2

Добавляем поддержку RAID1.

root@kvm0:~# echo 'GRUB_DISABLE_LINUX_UUID=true' >> /etc/default/grub

root@kvm0:~# echo 'GRUB_PRELOAD_MODULES=”raid dmraid”' >> /etc/default/grub root@kvm0:~# echo raid1 >> /etc/modules

root@kvm0:~# echo raid1 >> /etc/initramfs-tools/modules

Устанавливаем загрузчик на оба диска.

root@kvm0:~# grub-install /dev/sda –recheck

Installation finished. No error reported.

root@kvm0:~# grub-install /dev/sdb –recheck

Installation finished. No error reported.

root@kvm0:~# update-grub

Generating grub.cfg …

Found linux image: /boot/vmlinuz-2.6.32-20-pve

Found initrd image: /boot/initrd.img-2.6.32-20-pve

Found memtest86+ image: /memtest86+.bin

Found memtest86+ multiboot image: /memtest86+_multiboot.bin

done

root@kvm0:~# update-initramfs -u

update-initramfs: Generating /boot/initrd.img-2.6.32-20-pve

5. Перенос LVM на /dev/md1, перевод исходного диска в RAID1

Добавляем boot-раздел на исходном диске /dev/sda в RAID1.

root@kvm0:~# sfdisk -c /dev/sda 1 fd

Done

root@kvm0:~# mdadm –add /dev/md0 /dev/sda1

mdadm: added /dev/sda1

Теперь нам нужно перенести данные с LVM-раздела /dev/sda2 в /dev/md1. Перенос данных при помощи pvmove занимает довольно большое время, поэтому дальнейшие действия выполняем в screen'е.

root@kvm0:~# screen bash

root@kvm0:~# pvcreate /dev/md1 Writing physical volume data to disk “/dev/md1” Physical volume “/dev/md1” successfully created

root@kvm0:~# vgextend pve /dev/md1 Volume group “pve” successfully extended

root@kvm0:~# pvmove /dev/sda2 /dev/md1 /dev/sda2: Moved: 2.0% /dev/sda2: Moved: 14.5% /dev/sda2: Moved: 17.5% /dev/sda2: Moved: 19.2% /dev/sda2: Moved: 20.3% /dev/sda2: Moved: 24.7% /dev/sda2: Moved: 31.4% /dev/sda2: Moved: 32.5% /dev/sda2: Moved: 43.6% /dev/sda2: Moved: 63.3% /dev/sda2: Moved: 81.4% /dev/sda2: Moved: 100.0%

root@kvm0:~# vgreduce pve /dev/sda2 Removed “/dev/sda2” from volume group “pve”

Добавляем второй раздел исходного диска в RAID1.

root@kvm0:~# sfdisk –change-id /dev/sda 2 fd

Done

root@kvm0:~# mdadm –add /dev/md1 /dev/sda2

mdadm: added /dev/sda2

Наливаем себе чашечку кофе и наблюдаем за синхронизацией массива через cat /proc/mdstat.

На этом миграция Proxmox 3.0 VM в software RAID1 завершена.

URLs:

pve.proxmox.com/wiki/Software_RAID

pve.proxmox.com/wiki/Install_Proxmox_VE_on_Debian_Wheezy

dominicpratt.de/proxmox-ve-3-0-software-raid/

www.howtoforge.com/proxmox-2-with-software-raid

www.howtoforge.com/how-to-set-up-software-raid1-on-a-running-system-incl-grub2-configuration-debian-squeeze

Источник: http://www.pvsm.ru/linux/38832

Proxmox 1.6 поддержка RAID1

Из коробки райд не поддерживается? Даже железный?

Настраивал по этой статье

Помогло, вроде. 🙂

В повседневной работе появилась привычка резервировать данные. Обязательно RAID 1 (зеркало), резервное копирование.

После установки Proxmox VE в дефолтном режиме, но с двумя дисками – было обнаружено что система разметила и использует только один диск, что неприемлемо.

Ниже приведёно краткое руководство по переводу разделов диска в режим RAID 1. Итак, приступим (данное руководство делалось для версии 1.5 со стандартным ядром).

Установить Proxmox только на один первый диск (/dev/sda).

Доустановить необходимые пакеты для работы с RAID, создания рамдиска с драйверами:

aptitude install mdadm initramfs-tools

Загрузить модуль raid1:

Записать необходимые модули в /etc/modprobe.conf, пересоздать initrd:

echo alias md-personality-3 raid1 >> /etc/modprobe.conf

mkinitramfs -o /boot/initrd.img-`uname -r`-raid1 -r /dev/mapper/pve-root

Отредактировать GRUB, чтобы загрузка производилась с новым initrd:

title Proxmox Virtual Environment, kernel 2.6.18-2-pve on RAID1 root (hd0,0) kernel /vmlinuz-2.6.18-2-pve root=/dev/mapper/pve-root ro.

initrd /initrd.img-2.6.18-2-pve-raid1

Разметить второй диск (/dev/sdb) примерно так:

Device Boot Start End Blocks Id System /dev/sdb1 * 1 63 506016 fd Linux raid autodetect

/dev/sdb2 64 60801 487877985 fd Linux raid autodetect

Т. е. первый раздел под /boot – 512 Mb, остальное под второй раздел для LVM (данный раздел не должен быть меньше используемого на первом диске).

Далее создаются RAID-разделы с использованием пока только второго диска:

mdadm –create /dev/md0 –level=1 –raid-devices=2 missing /dev/sdb1

mdadm –create /dev/md1 –level=1 –raid-devices=2 missing /dev/sdb2

mdadm –detail –scan >> /etc/mdadm/mdadm.conf

Теперь нужно создать LVM-раздел на втором диске, добавить его в группу pve, переместить данные с LVM-раздела первого диска, на RAID-LVM-раздел второго диска, убрать из LVM первый диск:

pvcreate /dev/md1

vgextend pve /dev/md1

pvmove /dev/sda2 /dev/md1

vgreduce pve /dev/sda2

Теперь нужно подготовить RAID-раздел второго диска, скопировать на него /boot:

mkfs.ext3 /dev/md0

mkdir /mnt/md0

mount /dev/md0 /mnt/md0

cp -ax /boot/* /mnt/md0

umount /mnt/md0

rmdir /mnt/md0

Исправить /etc/fstab, поменять запись о /boot так, чтобы она указывала на RAID-раздел:

/dev/md0 /boot ext3 defaults 0 1

Можно перемонтировать /boot:

Переразметить первый диск в соответствии со вторым (у меня так почему-то не получилось, переразмечал вручную):

sfdisk -d /dev/sdb | sfdisk /dev/sda

Теперь можно добавлять в RAID-массивы разделы первого диска:

mdadm –add /dev/md0 /dev/sda1

mdadm –add /dev/md1 /dev/sda2

Нужно подождать пока RAID синхронизируется, контролировать процесс можно при помощи такой команды:

watch -n 1 “cat /proc/mdstat”

Теперь нужно переинсталировать загрузчик (GRUB) на обоих дисках:

grub > find /grub/stage1 find /grub/stage1 (hd0,0) (hd1,0) > root (hd0,0) > setup (hd0) > root (hd1,0) > setup (hd1)

> quit

Или такой вариант (не проверял лично):

grub-install /dev/sda

grub-install /dev/sdb

Всё, система работает на RAID1 (зеркале).

Источник: http://vr-77.blogspot.com/2010/10/proxmox-16-raid1.html

Proxmox 4.0: Корневой раздел на ZFS RAID1 или как увеличить отказоустойчивость если в сервере всего 2 диска

Подвернулась мне задача — запустить Proxmox и несколько виртуалок на сервере всего с 2 дисками. При этом требовалось обеспечить ну хоть какую-то надежность и простоту исправления проблем связанных с выходом из строя одного из дисков. Далее в заметке подробное описание тестирования решения на стенде.

Вводная

Я считаю что читатель данной заметки может самостоятельно установить Proxmox на ноду и не буду рассматривать установку и настройку самого гипервизора. Рассмотрим только настройки касающиеся ZFS RAID1 и тестирование ситуации сбоя одного из дисков.

Железо на котором предстояло развернуть проект представляло из себя ноду Supermicro, видимо в исполнении 2 node in 1U с псевдо-рейдом интегрированном в чипсет от Intel который не поддерживается в Proxmox.

В связи с этим попробуем испытать решение предлагаемое «из коробки» в версии 4.0. Хоть убейте — я не помню был-ли такой вариант установки в Proxmox 3.6, может и был, но не отложилось в памяти из-за невостребованности такой конфигурации.

В тестовой стойке у нас отыскался аналогичный сервер и я принялся за проверку решения, предоставляемого ребятами из Proxmox Server Solutions.

Установка

Как и предупреждал — не буду показывать установку полностью, заострю внимание только на важных моментах.

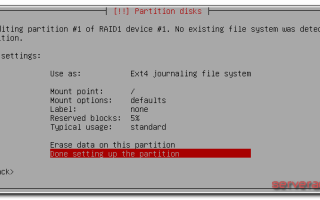

Выбираем zfs RAID1:

Сервер тестовый и нет подписки на коммерческий репозиторий. В /etc/apt/sources.list подключаем бесплатный:

deb http://download.proxmox.com/debian jessie pve-no-subscription

В /etc/apt/sources.list.d/pve-enterprise.list закомментируем коммерческий.

Ну и вдруг забудете:

root@pve1:~# apt-get update && apt-get upgrade

Смотрим что нам нарезал инсталлятор на дисках (привожу только часть вывода):

root@pve1:~# fdisk -l /dev/sd* Disk /dev/sda: 149.1 GiB, 160041885696 bytes, 312581808 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: gpt Disk identifier: 758FA29C-4F49-4315-BA0C-F3CCC921FA01 Device Start End Sectors Size Type /dev/sda1 34 2047 2014 1007K BIOS boot /dev/sda2 2048 312565389 312563342 149G Solaris /usr & Apple ZFS /dev/sda9 312565390 312581774 16385 8M Solaris reserved 1 Disk /dev/sdb: 149.1 GiB, 160041885696 bytes, 312581808 sectors Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: gpt Disk identifier: 3CD4B489-A51D-4354-8018-B1391F52B08D Device Start End Sectors Size Type /dev/sdb1 34 2047 2014 1007K BIOS boot /dev/sdb2 2048 312565389 312563342 149G Solaris /usr & Apple ZFS /dev/sdb9 312565390 312581774 16385 8M Solaris reserved 1

Глянем на наш массив:

root@pve1:~# zpool status rpool pool: rpool state: ONLINE scan: none requested config: NAME STATE READ WRITE CKSUM rpool ONLINE 0 0 0 mirror-0 ONLINE 0 0 0 sda2 ONLINE 0 0 0 sdb2 ONLINE 0 0 0 errors: No known data errors

По умолчанию инсталлятор Proxmox установил загрузчик на оба раздела — отлично!

Тестирование

Имитируем отказ жесткого диска следующим образом: — выключаем сервер; — выдергиваем одну из корзин;

— включаем сервер.

Источник: http://savepearlharbor.com/?p=269554

Перевод дисков после инсталляции Proxmox VE в RAID1 (mirror) by Блог Александра Руденко aka ras

В повседневной работе появилась привычка резервировать данные. Обязательно RAID 1 (зеркало), резервное копирование.

После установки Proxmox VE в дефолтном режиме, но с двумя дисками — было обнаружено что система разметила и использует только один диск, что неприемлемо.

Ниже приведёно краткое руководство по переводу разделов диска в режим RAID 1. Итак, приступим (данное руководство делалось для версии 1.5 со стандартным ядром).

Установить Proxmox только на один первый диск (/dev/sda).

Доустановить необходимые пакеты для работы с RAID, создания рамдиска с драйверами:

aptitude install mdadm initramfs-tools parted screen

Загрузить модуль raid1:

modprobe raid1

Разметить второй диск (/dev/sdb) примерно так:

Device Boot Start End Blocks Id System /dev/sdb1 * 1 52 417658+ fd Linux raid autodetect /dev/sdb2 53 121601 976342342+ fd Linux raid autodetect

Т. е. первый раздел под /boot — 400-500 Mb, остальное под второй раздел для LVM (данный раздел не должен быть меньше используемого на первом диске).

Далее создаются RAID-разделы с использованием пока только второго диска:

mdadm –create /dev/md0 –metadata=0.90 –level=1 –raid-devices=2 missing /dev/sdb1 mdadm –create /dev/md1 –level=1 –raid-devices=2 missing /dev/sdb2 mdadm –detail –scan >> /etc/mdadm/mdadm.conf

Создать резервную копию и пересоздать initrd:

cp -f /boot/initrd.img-`uname -r` /boot/initrd.img-`uname -r`~ mkinitramfs -o /boot/initrd.img-`uname -r` -r /dev/mapper/pve-root

Теперь нужно создать LVM-раздел на втором диске, добавить его в группу pve, переместить данные с LVM-раздела первого диска, на RAID-LVM-раздел второго диска, убрать из LVM первый диск (pvmove занимает длительное время, следующий набор операций лучше запускать в screen, чтобы процесс не прервался, если вы подключены к серверу удалённо):

pvcreate /dev/md1 vgextend pve /dev/md1 pvmove /dev/sda2 /dev/md1 vgreduce pve /dev/sda2

Теперь нужно подготовить RAID-раздел второго диска, скопировать на него /boot:

mkfs.ext3 /dev/md0 mkdir /mnt/md0 mount /dev/md0 /mnt/md0 cp -ax /boot/* /mnt/md0 umount /mnt/md0 rmdir /mnt/md0

Исправить /etc/fstab, поменять запись о /boot так, чтобы она указывала на RAID-раздел:

/dev/md0 /boot ext3 defaults 0 1

Можно перемонтировать /boot:

umount /boot mount /boot

Переразметить первый диск в соответствии со вторым (предварительно нужно удалить все разделы с /dev/sda):

parted /dev/sda rm 2 parted /dev/sda rm 1 sfdisk -d /dev/sdb | sfdisk /dev/sda

Теперь можно добавлять в RAID-массивы разделы первого диска:

mdadm –add /dev/md0 /dev/sda1 mdadm –add /dev/md1 /dev/sda2

Нужно подождать пока RAID синхронизируется, контролировать процесс можно при помощи такой команды (на больших разделах данный процесс может занять много времени):

watch -n 1 “cat /proc/mdstat”

Теперь нужно переинсталировать загрузчик (GRUB) на обоих дисках (для grub, с grub2 данныяй метод не работает, смотри ниже):

grub > find /grub/stage1 find /grub/stage1 (hd0,0) (hd1,0) > root (hd0,0) > setup (hd0) > root (hd1,0) > setup (hd1) > quit

Для grub2:

grub-install /dev/sda grub-install /dev/sdb

Всё, система работает на RAID1 (зеркале).

Ссылки:

- pve.proxmox.com/wiki/Downloads — сайт загрузки Proxmox VE

Comments

comments

Источник: http://rudenko.net.ua/?p=184

Установка proxmox на debian wheezy

Уже давно слышал об этой системе виртуализации (http://ru.wikipedia.org/wiki/Proxmox)…

Это система, использующая в качестве гипервизоров KVM и OpenVZ и имеющая удобный веб-интерфейс для управления.Итак, имеется прокачанный домашний компьютер с Debian Wheezy 7.3 (amd64) на борту. Когда я наконец-то собрался ставить – оказалось, что теперь, с выходом новой версии Proxmox 3.1 изменилась политика предоставления доступа к репозиториям.

Здесь (https://pve.proxmox.com/wiki/Package_repositories) можно найти описания репозиториев. Вижу, что Proxmox VE Enterprise Repository не подходит – на него платная подписка.

Официальное руководство (http://pve.proxmox.

com/wiki/Install_Proxmox_VE_on_Debian_Wheezy) настоятельно рекомендует ставить Proxmox VE No-Subscription Repository, однако пугает описание этого репозитория: “The pve-no-subscription repo can be used for testing and non-production use.

Its not recommended to run on production servers as these packages are not always heavily tested and validated. As the name suggests, there is no Proxmox VE Subscription Key needed to access this repository.”

Что же делать? Я решил попробовать поставить версию 3.0 – стабильный предыдущий релиз.

Добавим строку в пакетный менеджер:

echo “deb http://download.proxmox.com/debian wheezy pve” >> /etc/apt/sources.list

Дальше, проделаем, как описано в документации. Ставим ключ репозитория:

wget -O- “http://download.proxmox.com/debian/key.asc” | apt-key add –

Затем обновим список пакетов и поставим имеющиеся на данный момент обновления (я использую aptitude):

aptitude update && aptitude safe-upgrade

Ставим ядро:

aptitude install pve-firmware pve-kernel-2.6.32-26-pve

При этом система у меня поругалась:

Следующие пакеты имеют неудовлетворённые зависимости: pve-firmware : Конфликтует: firmware-linux-free но установлен 3.2 Конфликтует: firmware-linux-free:i386 который является виртуальным пакетом. Конфликтует: firmware-realtek но установлен 0.36+wheezy.

1 Конфликтует: firmware-realtek:i386 который является виртуальным пакетом. Следующие действия разрешат зависимости: Удалить следующие пакеты: 1) firmware-linux-free 2) firmware-realtek Оставить следующие зависимости неразрешёнными: 3) linux-image-3.2.

0-4-amd64 рекомендует firmware-linux-free (>= 3~) Принять данное решение? [Y/n/q/?]

я принял данное решение, так как далее разработчики proxmox предлагают удалить ядро linux-image-3.2.0-4-amd64

Проверив после перезагрузки, что всё работает с ядром pve-kernel-2.6.

32-26-pve, смело удаляем ядро, которое стояло по умолчанию:

aptitude remove linux-image-amd64 linux-image-3.2.0-4-amd64

Проверяем конфигурацию загрузчика:

update-grub

Теперь ставим пакеты Proxmox VE:

aptitude install proxmox-ve-2.6.32 ntp ssh lvm2 postfix ksm-control-daemon vzprocps open-iscsi bootlogd

Вводим https://ваше-имя-хоста:8006/ и радуемся!

Ошибки при установке Proxmox на Debian

[1] Proxmox: initscript rrdcached, action “start” failed

У меня установка proxmox-ve-2.6.32 и его зависимостей прервалась специфической ошибкой:

Настраивается пакет rrdcached (1.4.7-2) … Starting RRDtool data caching daemon: rrdcachedBase directory (-b) resolved via file system links! Please consult rrdcached '-b' documentation! Consider specifying the real directory (/media/all/var/lib/rrdcached/db) invoke-rc.

d: initscript rrdcached, action “start” failed.

dpkg: ошибка при обработке параметра rrdcached (–configure): подпроцесс установлен сценарий post-installation возвратил код ошибки 5 dpkg: зависимости пакетов не позволяют настроить пакет pve-cluster: pve-cluster зависит от rrdcached, однако: Пакет rrdcached пока не настроен.

Это произошло из-за того, что я сделал каталог /var символический ссылкой с каталога, находящегося на обычном жёстком диске, в то время, как корень системы находится на SSD. Можно было, конечно, примонтировать, но мне было лень создавать отдельный раздел для /var, поэтому я использовал тот же раздел, где лежит /home. У вас не должно быть такой проблемы.

Поборол её так:

1) определяем, где хранится конфигурация

dpkg -L rrdcached … /etc/default/rrdcached …

2) открываем файлы и раскоментируем параметр, указав реальное место папки без символических ссылок:

nano /etc/default/rrdcached … OPTS=”-b /media/all/var/lib/rrdcached/db” …

[2] Proxmox: Unable to get local IP address

Настраивается пакет pve-cluster (3.0-8) … [….] Starting pve cluster filesystem : pve-cluster[main] crit: Unable to get local IP address (warning). invoke-rc.d: initscript pve-cluster, action “start” failed.

Как поборол (rocknroothost – это моё имя хоста, вам нужно подставить своё):

cp -av /etc/hosts /etc/hosts.original

потом файл /etc/hosts приводим к виду:

— 127.0.0.1 localhost.localdomain localhost 192.168.99.99 rocknroothost.pp.ua rocknroothost pvelocalhost —

также файл /etc/hostname приводим к виду:

— rocknroothost —

затем выполнить:

apt-get install -f

и установка продолжится

/etc/init.d/hostname.sh start

[3] Proxmox: failed to load

Наконец, намучившись с установкой, ввожу в браузер:

http://rocknroothost:8006/ => получаю ошибку: failed to load, проверяю, что служба работает

lsof -i tcp:8006

ломаю голову, гуглю… но это просто смешно – нужно было смотреть внимательно:

https и не http

Источник: http://rocknroot.pp.ua/blog.ustanovka-proxmox-na-debian-wheezy.html

Установка Proxmox VE на Debian 7 (Wheezy), а так же рабочие момены

На официальном сайте Proxmox VE есть официальное же руководство по установке Proxmox VE на уже работающий Debian. Все инструкции в интернете не что иное, как отсебячий перевод, без комментариев и разбора спорных моментов. В данной статье я привожу опять же перевод, но с некоторыми комментариями и объяснениями не однозначных моментов.

Самое первое о чем хотелось бы порассуждать, это причины по которым большинство народу ставит Proxmox VE на уже настроенный Debian, а не пользуется готовым дистрибутивом.

1. Возможность сделать LVM.

2. Специфическая разбивка дисков (не берем во внимание ситуации, когда используется аппаратный RAID с отсутствующими в сборке драйверами, или когда надо сделать программный RAID).

Начнем со второй причины, а именно с разбивки дисков.

Конечно же я понимаю иногдашную необходимость в какой то экзотической разбивке дисков, скажем, сделать /var поболее и на отдельном разделе, дабы хранить логи годами, или как то так.

Но если использовать имеющуюся машину только как сервер виртуализации, надо ли это? Proxmox VE генерирует не так много логов, система в дистрибутиве идет минимальная, а большой /home вполне пригодится для хранения шаблонов и исошников.

Отсюда мой вывод, специфической разбивкой дисков можно пренебречь и использовать предложенную в дистрибутиве Proxmox VE.

Теперь первая и самая главная причина, это LVM.

Мало кто задумывается для чего нужен LVM в системах виртуализации, многие заканчивают думать на такой мысли: «LVM позволяет делать снапшоты, и это круто, я смогу бэкапить машины не прерывая их работы.

Или делать снапшоты (снимки), а после изменений возвращаться к ним, как делаю это в VirtualBox или VMware Workstation«.

Но тут ждет разочарование, во первых, снапшоты (тут надо уточнить, под снапшотом тут понимается бэкап машины без прерывания ее работы) на LVM сильно тормозят виртуальную машину и всю дисковую систему сервера, а во вторых, в Proxmox VE на LVM доступен только RAW формат дисков, а он не поддерживает снапшоты в классическом понимание (как снимки в VirtualBox или VMware Workstation), остаются только снапшоты средствами самого LVM, но это опять же дикие тормоза ведь когда есть LVM снапшот, то при записи данных на LV экстент сначала переписывается на снапшотный том и только потом на него записываются новые данные. То есть, запись на том приводит к двум дополнительным операциям: чтению оригинального дома + записи на снапшот. Эти лишние операции и съедают скорость. И чем больше снапшотов, тем медленнее работает дисковая систем. К тому же попытки сделать такой снапшот через консоль (в обход веб морды) почему то в 90% случаев гробят машину.

Нахрена же нужен вообще тогда этот LVM спросите вы, ответ находится немного не в том месте, на которое устремлены взгляды общественности.

Дело в том, что при создание жесткого диска как объекта (файла) в файловой системе сервера, этот жесткий диск подвержен всем влияниям (достоинствам и недостаткам) той файловой системы на которой находится. Так же этот объект пострадает в случае повреждения родительской файловой системы.

Что же касается LVM, то при его использование жесткий диск виртуальной машины по сути является разделом, никак не относящимся к родительской системе и ее файловой системе в частности, от этого и увеличение производительности за счет сокращения уровней абстракции (нет наслоения файловых систем одной на другу, если так можно выразится), к RAW дискам находящимся на LVM нет необходимости применять кэширование, что благотворно влияет на надежности системы.

Про кэширование хотелось бы упомянуть более подробно. Кэширование, это такая штука, которая применяется и на уровне хост системы (родительской) к контейнеру жесткого диска виртуальной машины, как обычному фалу (настраивается в вэб морде), и на уровне виртуальной машины (ОС самой машины).

Отсюда вытекает проблема надежности «конструкции», так как дисковый кэш это передержка данных в оперативной памяти, и каждая система отвечает за этот процесс сам (хост и гостевая), в случае падения гостевой системы, данные находящиеся в оперативной памяти хост системы с очень большой вероятностью не верно запишутся в образ жесткого диска, чем похерят его и соответственно виртуальную машину (классно так, на ровном месте из за бзода виртуальной машины потерять ее). Это происходит из за того, что хост система не знает о кэширование гостевой системы, гостевая система применяя кэш периодически сбрасывает данные на свой диск, но при падение, это процесс не завершается, а хост система не может его завершить, так как она не в курсе чего и куда, она видит завершение процесса доступа к файлу и тупо очищает блоки памяти.

Более четко не могу сформулировать, тут лучше было бы нарисовать этот процесс, но мне лень.

А теперь непосредственно установка Proxmox VE на новенький Debian 7 (Wheezy).

Первым делом правим файл /etc/hosts так, чтобы имя сервера (которое было указано при установке) разрешалось не 127.0.1.1, а в тот ip который присвоен интерфейсу через который будем управлять Proxmox VE, без этого Proxmox VE не установится.

127.0.0.1 localhost

192.168.1.1 sr2.itroad.ru sr2

Далее добавляем в список репиозиториев репозиторй Proxmox VE

deb http://mirror.yandex.ru/debian/ stable main non-free

deb-src http://mirror.yandex.ru/debian/ stable main non-free deb http://security.debian.org/ stable/updates main non-free

deb-src http://security.debian.org/ stable/updates main non-free deb http://mirror.yandex.ru/debian stable-updates main non-free

deb-src http://mirror.yandex.ru/debian stable-updates main non-free # Репозиторий Proxmox VE

deb http://download.proxmox.com/debian wheezy pve-no-subscription

Добавляем ключ репозитория и обновляемся

wget -O- “http://download.proxmox.com/debian/key.asc” | apt-key add –

aptitude update

aptitude upgrade

Смотрим какое pve ядро есть на данный момент и ставим его вместе с pve-firmware (пропиетарные дровишки для разного оборудования).

Источник: https://www.itroad.ru/ustanovka-proxmox-ve-na-debian-7-wheezy

Терминальный сервер Debian 9.3 в LXC контейнере Proxmox VE 5.1 (часть 1 установка, базовая настройка)

Очередной раз устанавливаю виртуалку с терминальным сервером Linux и решил собрать в одном месте все актуальные этапы/нюансы установки и настройки (мир не стоит на месте, некоторые вещи меняются).

Ставить буду в LXC контейнере Proxmox VE (аналог jails FreeBSD).

Преимущество – отсутствие накладных расходов на виртуализацию, недостаток – на данном этапе развития проекта, миграция между гипервизорами только через выключение(нет “живой” миграции), но, так как включение-выключение-миграция практически мгновенные, это не критично.

В пользовательском интерфейсе Proxmox VE идем на local хранилище узла, выбираем вкладку “Содержимое”, жмем кнопку “Шаблоны”, выбираем нужный шаблон(в моем случае Debian-9.0-standatd)

Загружаем шаблон.

Жмем в правом верхнем углу интерфейса кнопку “Создать СТ” и следуем всем этапам создания контейнера, вводя требуемые данные и нажимая далее:Настраиваем опции вновь созданного контейнераЯ выбираю тип консоли Shell. Запускаем виртуалку и идем в консоль. Обновляем систему:

apt update

apt upgrade устанавливаем необходимый минимум:

apt install -y mc openssh-server lxde xrdp

apt remove xscreensaver локализуем dpkg-reconfigure localesотмечаем пробелом русскую UTF8 локаль

делаем ее локалью по умолчанию.Разрешаем для root ssh:

/etc/ssh/sshd_config

при этом старое значение не удаляю, а комментирую, чтоб после ввода сервера в эксплуатацию вернуть настройки назад. Разрешаем всем подключаться к Х серверу:dpkg-reconfigure xserver-xorg-legacy

В случае необходимости конфигурируем RDP параметры путем изменения настроек в /etc/xrdp/xrdp.ini

например new_cursor=false для убирания черного квадрата в страрых версиях клиентов

и

/etc/xrdp/sesman.ini

в /etc/xrdp/xrdp.ini можно закомментировать ненужные варианты подключений.

После перезагрузки root может подключаться по SSH и RDPРадикальное решение для проблем с раскладкой клавиатуры: В моем случае необходимы us,ru,ua

- Смотрим необходимые раскладки здесь и проверяем наличие .

ini файла для ваших раскладок в папке : /etc/xrdp/ (в моем случае для украинского языка файлика km-00000422.

ini не оказалось)

- Заходим в графическом режиме в терминал с правами рута или делаем sudo и выполняем для отсутствующих кейлайоутов:

xrdp-genkeymap km-00000422.ini

mv km-00000422.ini /etc/xrdp

- Правим xrdp_keyboard.ini до примерно такого вида:

- Желаемую комбинацию переключения можно посмотреть в настройках клавиатурного индикатора, но после вернуть птичку использовать системные.

Удаляем lxpolkit, иначе у всех пользователей, кроме первого будет при подключении высвечиваться окошко с его руганью

apt remove lxpolkit

Добавляем поддержку печати:

apt install cups

драйвера принтеров HP:

apt install -y printer-driver-hpcups

чтобы пользователи могли сами себе принтер по умолчанию выбрать:

apt install -y system-config-printer

Базовая настройка завершена. PS. Обнаружен интересный глюк:

При выключении поддержки IPv6 перестает запускаться служба XRDP, я просто включил ее назад.

Я специально не создавал пользователей, так как планирую использовать доменных, если планируется использование системных следующую часть можно пропустить и продолжать с части 3 продолжение базовой настройки. Тут я прерываюсь, так как для продолжения мне нужен обычный пользователь(в моем случае доменный).

Источник: https://a-katyrev.blogspot.com/2018/08/debian-93-lxc-proxmox-ve-51-1.html

Установка proxmox на debian

За основу взята статья из официальной wiki Install Proxmox VE on Debian Wheezy Предполагается, что читатель знаком с процессом установки Debian, знает основы mdraid, LVM, и процедуру подготовки дисков.

Предпосылки:

Собственно, она одна: при установке proxmox с дистрибутива нет возможности вручную разбить диски, как следствие нельзя установить proxmox на софтварный RAID.

Как разбиваем диски:

Раздел “/boot” ставим отдельно на raid-1, раздел “/” ставим отдельно на любой raid, и еще предусматриваем раздел для данных это тоже будет raid (в идеале 10, можно 1, но ни в коем случае не рекомендую 5), поверх него ставим LVM (надо для проксмокс что бы тот мог делать снапшоты).

Итак, при установке делаем на каждом диске следующие разделы:

swap (общий объем = ОЗУ)

md0 (делаем RAID1 ) “/boot” (общий размер 500Мб)

md1 (RAID1 или RAID10 или RAID5) “/” (общий объем 50Гб)

md2 (RAID1 или RAID10) это будет физический том для LVM

Установка:

Ставим debian при этом разбиваем диски как указано выше.

Подготовка раздела для данных proxmox (в команде lvcreate после ключа -l вставить размер Total PE):

aptitude install lvm2

pvcreate /dev/md2

vgcreate pve /dev/md2

vgdisplay | grep “Total PE”

lvcreate -l –name data pve

mkfs -t ext3 /dev/pve/data

mkdir /var/lib/vz

mount /dev/mapper/pve-data /var/lib/vz

Добавляем строку в /etc/fstab

# pve-data

/dev/mapper/pve-data /var/lib/vz ext3 noatime 0 0

Сеть должна быть со статическим IP, по этому в /etc/network/interfaces

# The primary network interface

allow-hotplug eth0

auto eth0

iface eth0 inet static

address 192.168.100.20

netmask 255.255.255.0

gateway 192.168.100.1

А в /etc/hosts (kn20 – имя нашего сервера)

Очень важно прописать наш хост в hosts! Если этого не сделать, то proxmox не сможет определить свое имя и не запустится. В той версии proxmox которую я ставил (3.2-4) есть еще косяк – proxmox не поддерживает IPv6, и если в hosts есть строки с IPv6, то prxmox не может его распарсить и опять же не может определить собственное имя и по этому не запускается

192.168.100.20 kn20.caesber.local kn20

Добавляем в файл /etc/apt/sources.list репозиторий:

# PVE pve-no-subscription repository provided by proxmox.com, NOT recommended for production use

deb http://download.proxmox.com/debian wheezy pve-no-subscription

Устанавливаем ключи репозитория Proxmox и делаем апдейт его и системы

wget -O- “http://download.proxmox.com/debian/key.asc” | apt-key add –

apt-get update && apt-get dist-upgrade

Устанавливаем ядро:

apt-get install pve-firmware pve-kernel-2.6.32-26-pve

apt-get install pve-headers-2.6.32-26-pve

Перезагружаемся в это ядро, проверяем, удаляем старое ядро:

uname -a

Linux kn20 2.6.32-26-pve…

apt-get remove linux-image-amd64 linux-image-3.2.0-4-amd64

update-grub

Устанавливаем Proxmox VE

apt-get install proxmox-ve-2.6.32 ntp ssh lvm2 postfix ksm-control-daemon vzprocps open-iscsi bootlogd

Заходим на web-морду (https://192.168.100.20:8006/) , настраиваем vmbr0 и перезагружаемся (изображение ниже взято из wiki, по этому адреса другие, привел просто для примера как должно выглядеть и на какой вкладке настраивать)

ГОТОВО!

Источник: http://valynkin.ru/ustanovka-proxmox-na-debian.html

Глава 1. Установка Proxmox

В данной главе мы охватим следующие основы Proxmox:

- Требования к аппаратным средствам

- Подготовку к установке

- Установку Proxmox на голом узле

- Установку Proxmox на Debian системы

- Подписки Proxmox

- Запрет подписок Proxmox

- Применение подписок Proxmox

- Установку репозитория пакетов Proxmox

- Поиск поддержки

Virtual Environment (VE) (виртуальня среда) Proxmox является многоузловым кластерным гипервизором с открытым исходным кодом, построенным на Debian Linux и способным работать на общедоступных аппаратных средствах, те самым устраняя любые блокировки вендора.

Proxmox свободно доступен без каких-либо блокированных особенностей. Тем не менее, доступна лицензия подписного типа для доступности репозитория уровня предприятия для получения хорошо проверенных патчей и обновлений.

Подписки рекомендуются для Proxmox среды промышленного уровня.

| Гипервизор представляет собой программное обеспечение или встроенное ПО, которое создает слой между естественным оборудованием и операционной системой для формирования виртуальной среды создания и запуска виртуальных машин. Гипервизор эмулирует функции физического оборудования для предоставления виртуальным машинам выглядеть аналогично физическим ресурсам. |

Proxmox может быть настроен для работы в виртуальной среде всего нескольких узлов с виртуальными машинами или в среде с тысячами узлов. Поддерживая виртуальные машины KVM и OpenVZ на базе контейнеров, Proxmox VE является сегодня ведущим гипервизором.

Proxmox имеет чрезвычайно активное сообщество готовое оказывать помощь любым бесплатным пользователям Proxmox.

Кроме того, группа экспертов технической поддержки Proxmox в равной степени способно обрабатывать всех корпоративных пользователей с их критически важными виртуальными средами.

Как упоминалось ранее, Proxmox это мультиузловая среда, и это означает, что многие узлы могут образовывать единый кластер в котором виртуальная машина может быть перемещена на любой узел в кластере, тем самым делая возможной избыточную виртуальную среду. Весь Proxmox кластер может управляться через надежный графический интерфейс пользователя (GUI). В Proxmox VE 3.4 через GUI только один кластер является управляемым.

Вот некоторые из примечательные особенности Proxmox VE:

- Он обеспечивает мультиузловую кластерную среду для виртуализации. Ни один узел не выступает в качестве ведущего, тем самым устраняя единую точку отказа.

- Он обеспечивает высокую доступность (HA, High Availability) виртуальных машин.

- Он дает централизованное веб-управление и единый интерфейс для управления всем кластером.

- Консоль может быть доступна через безопасные VNC, SPICE и HTML5 на основе noVNC.

- Он обеспечивает поддержку многих источников аутентификации, таких как локальное применение Pluggable Authentication (РАМ), Microsoft ADS и LDAP.

- Proxmox cluster fie system (pmxcfs) может быть использована для для хранения файлов настройки для репликации в реальном времени на всех узлах с применением corosync http://en.wikipedia.org/wiki/Corosync_%28project%29

- Она обеспечивает ролевое управление разрешениями для объектов VMS, хранилищ, узлов, пулов и тому подобного.

- В отличие от SOAP, REST не является протоколом, но сочетает различные стандарты, такие как HTTP, JSON, XML и URI. Посетите http://www.restapitutorial.com для информации о базирующемся на REST API.

- Он предоставляет мощный встроенный межсетевой экран для хост- узлов и виртуальных машин.

- Он обеспечивает миграцию виртуальных машин между физическими узлами приналичии общего хранилища или без него.

- Он поддерживает типы систем хранения основного направления, такие как Ceph, NFS, ZFS, Gluster и ISCSI.

- Он предоставляет регистрацию по всему кластеру.

Требования к аппаратным средствам

Приведем здесь рекомендуемые конфигурации аппаратных средств для стабильно работающего кластера Proxmox:

- 64-битный процессор Intel или Amd

- Материнская плата с поддержкой двух- или четырех- ядерного Intel VT или Amd-V

- 16ГБ памяти ОЗУ

- Две карты сетевых адаптеров (NIC, Network Interface Card)

- RAID контроллер с устройством резервной батареи (BBU, Battery Backup Unit)

- Твердотельные диски (SSD, Solid State Drive) для операционной системы или SSD для совместно используемого узла

- Ограждающее оборудование только в случае необходимости высокой доступности

Следующая таблица приводит список конфигурации узла сервера, который может быть использован в промышленной среде:

| Процессор/ ЦПУ | Intel Xeon E5-2630 v3 2.4ГГц |

| Материнская плата | Intel S2600CP2 Dual LGA2011 |

| Оперативная память | Kingston 16 GB DDR3 Registered ECC |

| Источник питания | С резервированием |

Отметим, что пример конфигурации приводится исключительно для справки. Ваше требования будут варьироваться в зависимости от рабочей нагрузки и ожидаемой производительности.

Регулируйте требования к оборудованию в соответствии с пониманием того, что большее число ядер в гипервизоре повысит производительность виртуальных машин также как более высокое значение тактовой частоты используемого процессора.

При более высоком числе ядер между процессами может быть распределено большее число потоков (threads).

| Стоит упомянуть, что лучше выбрать процессор с бОльшим размером кэша для узла с большИм объемом памяти для минимизации доступа к основной памяти и максимизации производительности каждого процессорного ядра. |

Proxmox является кластерным гипервизором. Для того, чтобы построить кластер требуется, как минимум, два узла. Для преследуемых этой книгой целей убедитесь что вы располагаете достаточным количеством компонентов для установки двух узлов при выборе оборудования.

Хотя кластер Proxmox может быть установлен только на два узла, рекомендуется применять минимум три узла для промышленной среды.

Источник: http://support.mdl.ru/ProxmoxCookBook/content/Ch01.html

Ускоряем работу дисков ext4

Настроим лучшую свободную систему виртуализации Proxmox VE на Raid1 в операционной системе Debian 8. В качестве гипервизора система использует KVM и LXC, что позволяет виртуализировать все популярные операционные системы. Браузерная панель управления.

Вступление

Вышла новая 5 версия Proxmox и о ней я написал новую статью. Принцип моего использования системой не поменялся. В новой статье вы узнаете некоторые нюансы c которыми я столкнулся при переходе на новую версию.

Подробнее..

Первое что я стал изучать в Linux это была система виртуализации.

По множественным рекомендациям администраторы Linux не советуют использовать все виды серверных служб на одной системе в виду сложности обслуживания и крайней нестабильности.

В случае аппаратного выхода из строя компьютера придется устанавливать всё практически с нуля. Пользуясь системой виртуализации все можно восстановить очень быстро.

Основными моими требованиями было:

- Простота установки,

- Удобное управление,

- Установка разных систем OC (Linux, Windows и тд.),

- Удобная система архивирования,

- Информирование на почту об ошибках системы,

- Подключение ИБП с отключение системы при пропадании 220 вольт,

- Проброс портов USB в виртуальную систему.

Все виды не свободных систем управления виртуализацией или всё что связанно с Microsoft я отбросил в сторону и искал только свободный вариант. Единственная система которая устроила меня по всем параметрам это была система Proxmox.

Система Proxmox не поддерживает установку из коробки на mdadm для использования программного raid1, хотя есть система zfs. Может эта файловая система и хороша но мне она пока не нужна.

Система Proxmox базируется на OC Debian. У разработчика есть инструкция по установке системы, которую мы возьмем за основу.

Проверка аппаратной поддержки виртуализации

Проверка поддержки виртуализации в процессоре выполняется командой:

egrep '(vmx|svm)' /proc/cpuinfo =вывод команды= flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht tm pbe syscall nx lm constant_tsc arch_perfmon pebs bts rep_good nopl aperfmperf pni dtes64 monitor ds_cpl vmx tm2 ssse3 cx16 xtpr pdcm dca lahf_lm tpr_shadow dtherm

Если в выводе присутствует параметр svm (Secure Virtual Machines) — значит процессор с поддержкой аппаратной виртуализации от AMD, если vmx (Virtual Machine eXtension) — значит процессор Intel.

Если вывод пустой, то смотрите в bios на предмет включения виртуализации, в противном случае использовать Proxmox не получится.

Исходные параметры системы

- proxmox — название машины

- sevo44.loc — полное имя домена

- 192.168.0.150 — ip системы с Proxmox

- 192.168.0.106 — шлюз сети

- 255.255.255.0 — маска сети

- 2 жестких диска по 107,4 GB.

Установка Debian 8 на mdadm raid1

Скачиваем последнюю версию системы Debian-8.6.0-amd64-netinst.iso.

Скачать

Установка до начала работы с дисками

Создание RAID1

Общая схема создания raid1 массивов состоит из нескольких шагов:

- Создаем одинаковые разделы на дисках с типом «физический том для RAID»,

- Объединяем два одинаковых раздела в необходимый раздел RAID1,

- Форматируем наш RAID1 под нужный нам формат файловой системы.

В итоге у нас получилось:

- Загрузочный раздел /boot с меткой «загрузочный» и размером 500 MB форматом ext2,

- Корневой раздел / размером 50 GB форматом ext4.

Завершение установки Debian 8

Настройка Debian 8

Установка текстового редактора mc

Установку выполним командой:

apt-get -y install mc

Настроим редактор mc по умолчанию командой:

select-editor =вывод команды= Select an editor. To change later, run 'select-editor'. 1. /bin/nano /etc/apt/sources.list.d/pve-install-repo.list

Добавляем цифровую подпись Proxmox репозитория:

wget -O- “http://download.proxmox.com/debian/key.asc” | apt-key add –

Обновим репозитории и систему выполнив команду:

apt-get update && apt-get dist-upgrade

Перезагрузим систему:

reboot

Установка необходимых пакетов Proxmox

Установка производиться командой:

apt-get install proxmox-ve ssh postfix ksm-control-daemon open-iscsi systemd-sysv

В процессе установке необходимо будет настроить Postfix.

Выберем параметры:

- Интернет-сайт,

- proxmox.sevo44.loc — укажем полное название машины.

Если нам в последствии надо будет изменить настройки Postfix то выполнить это можно командой:

dpkg-reconfigure postfix

Перезагружаем систему, новое ядро Proxmox VE будет автоматически выбрано в меню загрузчика GRUB.

reboot

Отправка почты на внешний e-mail адрес

Отправим тестовое письмо пользователю root в котором отправим данные файла /etc/fstab:

cat /etc/fstab | mail -s Testmail root

Идем смотреть в логах выполнив команду:

cat /var/mail/local =вывод команды= From root@proxmox.sevo44.loc Wed Dec 28 10:53:07 2016 Return-Path: X-Original-To: root Delivered-To: root@proxmox.sevo44.loc Received: by proxmox.sevo44.loc (Postfix, from userid 0) id 6D99F2224F1; Wed, 28 Dec 2016 10:53:07 +0300 (MSK) To: root@proxmox.sevo44.loc Subject: Testmail Message-Id: Date: Wed, 28 Dec 2016 10:53:07 +0300 (MSK) From: root@proxmox.sevo44.loc (root) # /etc/fstab: static file system information. # # Use 'blkid' to print the universally unique identifier for a # device; this may be used with UUID= as a more robust way to name devices # that works even if disks are added and removed. See fstab(5). # # # / was on /dev/md1 during installation UUID=6219d7b4-1d25-4fd7-a382-e162d46114d7 / ext4 errors=remount-ro 0 1 # /boot was on /dev/md0 during installation UUID=bf5388b2-0dde-47ae-aaa6-b192123bce3d /boot ext2 defaults 0 2 /dev/sr0 /media/cdrom0 udf,iso9660 user,noauto 0 0 swap /swap swap defaults 0 0

Видим что письмо пришло.

Настроим чтобы эти письма пересылались на нужную нам внешнюю e-mail почту.

Открываем файл /etc/aliases для правки выполнив команду:

mcedit /etc/aliases =необходимые изменения= # Правим вписывая свой адрес root: local,info@sevo44.ru

В данном виде почта будет приходить как в локальный файл так и на почту. Можете выбрать что то одно.

Применим изменения выполнив команду:

newaliases

Можно еще раз отправить тестовое письмо и убедиться что оно пришло.

Удаление пакета ОС-Prober

apt-get remove os-prober

Удаление Debian kernel

apt-get remove linux-image-amd64 linux-image-3.16.0-4-amd64 linux-base

Проверим конфигурацию Grub командой:

update-grub

Для проверки работы дисковой подсистем в Proxmox есть утилита pveperf которую мы будем использовать.

Посмотрим все смонтированые разделы в системе:

df -h = вывод команды = Файловая система Размер Использовано Дост Использовано% Cмонтировано в udev 10M 0 10M 0% /dev tmpfs 1,6G 14M 1,6G 1% /run /dev/md1 230G 57G 162G 26% / tmpfs 3,9G 34M 3,9G 1% /dev/shm tmpfs 5,0M 0 5,0M 0% /run/lock tmpfs 3,9G 0 3,9G 0% /sys/fs/cgroup /dev/sde1 917G 651G 220G 75% /var/lib/vz/backup /dev/md0 91M 47M 40M 54% /boot /dev/md2 913G 758G 110G 88% /var/lib/vz/images /dev/md3 921G 861G 14G 99% /mnt/md3 /dev/fuse 30M 20K 30M 1% /etc/pve tmpfs 798M 4,0K 798M 1% /run/user/115 tmpfs 798M 0 798M 0% /run/user/0

Посмотрим информацию о необходимом разделе:

pveperf /var/lib/vz/images = вывод команды = CPU BOGOMIPS: 25535.20 REGEX/SECOND: 578497 HD SIZE: 912.93 GB (/dev/md2) BUFFERED READS: 145.76 MB/sec AVERAGE SEEK TIME: 22.12 ms FSYNCS/SECOND: 65.94 DNS EXT: 60.41 ms DNS INT: 2.62 ms (sevo44.loc)

Из вывода видно, что параметр FSYNCS маловат и надо его улучшить.

Откроем необходимый файл и сделаем изменения:

cat /etc/fstab = вывод части команды с необходимыми изменениями = /dev/md2 /var/lib/vz/images ext4 relatime,barrier=0 0 1

После перезагрузки системы Proxmox проверим результат:

pveperf /var/lib/vz/images = вывод команды = CPU BOGOMIPS: 25535.20 REGEX/SECOND: 578497 HD SIZE: 912.93 GB (/dev/md2) BUFFERED READS: 145.76 MB/sec AVERAGE SEEK TIME: 22.12 ms FSYNCS/SECOND: 1328.94 DNS EXT: 60.41 ms DNS INT: 2.62 ms (sevo44.loc)

Вот так поигравшись с настройками файловой системы ext4 мы значительно увеличили производительность дисковой системы. Варианты настройки могут быть разные и тут все зависит от ваших требований к данным на дисках.

Панель управления Proxmox

Теперь мы можем зайти по адресу https://192.168.0.150:8006 и увидеть после авторизации панель управления Proxmox.

Сообщение о том что не подключены платные репозитории можно конечно убрать, но после обновления системы оно появиться снова.

Давайте уважать разработчиков, раз они хотят чтобы мы видели это сообщение в свободной системе, то пусть так и будет.

Источник: https://sevo44.ru/ustanovka-proxmox-na-debian-8/