Создание и настройка виртуальной машины в VirtualBox

С помощью бесплатной программы VirtualBox вы можете создать на своем компьютере виртуальную машину с другой гостевой операционной системой. Программа виртуализации VirtualBox создает виртуальные машины, в которые можно будет установить разные операционные системы: Windows, Linux, Mac OS X и т.д.

В Виртуал Бокс на ваш компьютер будет установлен как бы виртуальный компьютер с другой (или другими) операционной системой, которая никак не будет затрагивать основную ОС, установленную на вашем компьютере. При помощи данной программы, вы можете одновременно работать в двух разных операционную системах, например, в Windows и Linux Mint, или в Windows 10 и Windows 8.1.

В такой виртуальной операционной системе можно будет выполнять разные действия: учиться работать в новой ОС, тестировать новые версии Windows, пробовать в работе незнакомые программы, запускать устаревшие приложения, которые уже не работают в вашей системе и т.д. Вы можете делать с виртуальной (гостевой) операционной системой все, что угодно, без всякого риска для основной системы.

Для этого не нужно будет создавать новые разделы на жестком диске, и устанавливать туда другую ОС. Все, что необходимо для создания виртуальной машины, сделает программа VirtualBox.

Подробнее об установке программы VirtualBox и пакета дополнений можно будет прочитать здесь. Далее мы рассмотрим процесс создания виртуальной машины и ее настройку. Программа VirtualBox полностью русифицирована.

Создание виртуальной машины в VirtualBox

Для запуска процесса создания виртуальной машины, в главном окне программы VirtualBox, нажмите на кнопку «Создать».

В окне «Укажите имя и тип ОС», вам нужно будет ввести имя новой виртуальной машины, далее выбрать тип и версию операционной системы. Созданная виртуальная машина будет идентифицироваться по этому имени, поэтому я рекомендую делать понятные имена.

В данном случае, на моем реальном компьютере установлена Windows 10, а я хочу установить на виртуальную машину Windows 7. Для того, чтобы избежать путаницы между версиями (можно будет установить несколько одинаковых систем разных выпусков), я дал гостевой системе подробное понятное имя.

Можно будет установить виртуальную машину в экспертном режиме (все настройки будут сгруппированы в нескольких окнах), или в подробном режиме, который мы сейчас рассмотрим.

Программа VirtualBox рекомендует минимальный объем оперативной памяти для данной виртуальной машины. Вы можете выбрать самостоятельно необходимый объем памяти. Здесь следует придерживаться такой рекомендации: нельзя превышать размер выделенной памяти, который отмечен на шкале зеленым цветом, чтобы в итоге, не иметь проблем, с работой создаваемой виртуальной машины.

Виртуальная память — это часть физической памяти вашего компьютера, которая будет использоваться в виртуальной машине. Виртуальная память выделяется из распоряжения основной (хостовой) операционной системы для работы гостевой операционной системы на виртуальной машине. Выделенная оперативная память будет использоваться только при работе данной виртуальной машины.

На моем компьютере находится 8 ГБ оперативной памяти, поэтому я могу выделить виртуальной машине половину объема — 4 ГБ. Вы можете выбрать свой размер объема оперативной памяти, передвигая курсор по шкале, или ввести размер памяти в цифровом значении в МБ. В дальнейшем, при необходимости, вы можете изменить объем выделяемой оперативной памяти в настройках этой виртуальной машины.

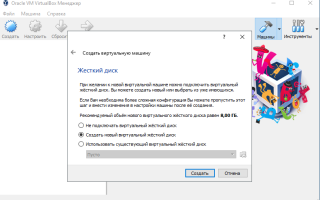

На следующем этапе необходимо будет создать виртуальный жесткий диск, так как виртуальная машина не сможет работать без такого жесткого диска. Виртуальный жесткий диск — это файл специального типа, который хранится в файловой системе ОС вашего компьютера.

В данном окне на выбор предлагаются три варианта действий:

- Не подключать виртуальный жесткий диск — вы можете подключить виртуальный жесткий диск после создания виртуальной машины

- Создать новый жесткий диск — будет создан новый виртуальный жесткий диск

- Использовать существующий виртуальный жесткий диск — к виртуальной машине будет подключен ранее созданный виртуальный жесткий диск

Программа VirtualBox сама рекомендует объем жесткого диска для конкретной операционной системы.

Для создания нового виртуального диска, нажмите на кнопку «Создать».

В следующем окне необходимо будет выбрать тип виртуального жесткого диска. Вы можете выбрать следующие форматы дисков (виртуальных контейнеров):

- VDI (VirtualBox Disk Image) — формат диска VirtualBox

- VMDK (Virtual Machine Disk) — формат диска VMware

- VHD (Virtual Hard Disk) — формат диска Microsoft

- HDD (Parallels Hard Disk) — формат диска Parallels

- QED (QEMU enhanced disk) — формат для QEMU/KVM

- QCOW (QEMU Copy-On-Write) — формат для QEMU (qcow2)

Если для создания и запуска виртуальных машин вы будете использовать только программу VirtualBox, то тогда можно оставить выбор по умолчанию: формат VDI. Диски этого формата будут открываться в программе Виртуал Бокс.

Формат VMDK подойдет в том случае, если вы будете использовать виртуальную машину VMware Player, или VMware Workstation. Создав виртуальную машину в VirtualBox, выбрав тип виртуального диска VMDK, вы сможете в дальнейшем запустить эту виртуальную машину с установленной операционной системой, не только в VirtualBox, но и в другой программе производства VMware.

После выбора типа диска, нажмите на кнопку «Next».

Далее нужно будет выбрать формат хранения: динамический или фиксированный.

Файл динамического жесткого диска будет занимать небольшое место на физическом жестком диске вашего компьютера. По мере заполнения данными он будет увеличиваться в размере до предельного объема.

Файл фиксированного жесткого диска сразу займет весь объем виртуального жесткого диска.

В новом окне необходимо будет указать имя и размер файла виртуального жесткого диска.

В поле для имени нужно будет написать имя виртуального жесткого диска. Я всегда указываю понятные названия для виртуальных машин для того, чтобы у меня была возможность без труда отличить файлы виртуальных контейнеров друг от друга.

По умолчанию, все файлы виртуальной машины будут сохранены в профиле пользователя на диске «С» вашего реального компьютера. Я рекомендую поступить по-другому: создать в другом (не системном) разделе диска вашего компьютера специальную папку (у меня она называется Virtual Machines), в которой можно будет хранить файлы виртуальных машин.

Если файлы виртуальной машины будут храниться в профиле пользователя на системном диске, то в случае, переустановки операционной системы, созданные ранее виртуальные машины, будут потеряны. Вам необходимо будет заново создавать виртуальную машину, а затем устанавливать туда операционную систему.

Файлы, сохраненные на другом разделе жесткого диска, или на другом жестком диске, в случае переустановки системы будут сохранены. После установки на компьютер программы виртуализации (VirtualBox или VMware), нужно будет только подключить и запустить ранее созданные виртуальные машины с операционными системами.

Для выбора папки хранения виртуальных машин используйте иконку с кнопкой папки. В окне Проводника выберите диск и папку для хранения данных виртуальной машины.

Затем на шкале укажите объем виртуального жесткого диска в мегабайтах. Для этого перетащите ползунок на нужное место, соответствующее вашим потребностям. После выбора настроек, нажмите на кнопку «Создать».

Виртуальная машина создана. После этого откроется главное окно «Oracle VM VirtualBox Менеджер» с вновь созданной виртуальной машиной. В правой части окна вы можете ознакомиться с некоторыми параметрами виртуальной машины.

Теперь необходимо будет сделать дополнительные настройки перед установкой операционной системы на виртуальную машину.

Настройки виртуальной машины в VirtualBox

В главном окне VirtualBox выделите виртуальную машину (если их несколько), а затем нажмите на кнопку «Настроить» для входа в настройки этой конкретной виртуальной машины.

В разделе «Общие», во вкладке «Дополнительно» вам нужно будет выбрать папку хранения для снимков системы (очень полезная функция).

По умолчанию снимки системы будут сохраняться в папке «Snapshost» в профиле пользователя на системном диске «С».

Вы можете создать папку с таким именем в том месте, где вы храните файлы этой виртуальной машины, для того, чтобы не потерять снимки при переустановке системы.

Необходимо также будет выбрать общий буфер обмена для того, чтобы обмениваться данными между основной реальной операционной системой, и гостевой виртуальной ОС. На выбор предлагается несколько вариантов:

- Выключен — настройка по умолчанию

- Из основной в гостевую ОС — вы можете перемещать информацию из основной системы в виртуальную ОС

- Из гостевой в основную ОС — вы можете перемещать данные из виртуальной ОС в основную систему

- Двунаправленный — данными можно будет обмениваться в обоих направлениях

Есть смысл выбрать двунаправленный общий буфер обмена для наибольшего удобства при работе.

Далее включите функцию Drag’n’Drop для того, чтобы включить возможность перетаскивания данных из окна одной системы, в окно другой при помощи мыши. Здесь также будет лучше выбрать двунаправленный вариант.

В разделе «Система», во вкладке «Материнская плата» можно будет настроить порядок загрузки виртуальной машины. С помощью кнопочек со стрелками вверх и вниз, выберите последовательность загрузки виртуальной машины. Имеет смысл сделать первым загрузочным устройством оптический диск, с гибкого диска можно будет вообще снять галочку из-за неактуальности такого способа.

При выборе первым загрузочным устройством оптического диска, загрузка системы может произойти, как с реального дисковода вашего компьютера, куда будет вставлен загрузочный диск DVD с операционной системой, так и с образа диска, например, в формате ISO, который физически находится где-нибудь на диске вашего компьютера.

После применения новых настроек, не забывайте нажимать на кнопку «ОК».

Во вкладке «Процессор» вы можете включить дополнительные ядра, в том случае, если процессор вашего компьютера многоядерный.

В разделе «Дисплей», во вкладке «Экран» вы можете выбрать объем видеопамяти, которую будет использовать виртуальная машина. Здесь вы можете включить 2D (необходимо) и 3D (необязательно) ускорение.

Во вкладке «Захват видео» вы можете включить функцию захвата видео в виртуальной машине.

В разделе «Носители» нужно будет выбрать виртуальный привод. Здесь уже отображается файл виртуального диска, но он почти пустой, так как операционная система еще не была установлена. Поэтому для установки системы нужно будет выбрать ISO файл образа с операционной системой.

Нажмите на «Пусто», в правой части окна напротив пункта «Оптический привод» нажмите на кнопку с изображением диска, а затем в контекстном меню выберите пункт «Выбрать образ оптического диска…». С помощью Проводника найдите на своем компьютере нужный образ операционной системы.

В разделах «Аудио», «Сеть», «COM-порты», «USB» можно оставить настройки по умолчанию, во многом эти настройки зависят от аппаратной части вашего компьютера.

В разделе «Общие папки» пока ничего нет, так как гостевая система еще не была установлена. Для функционирования общих папок понадобиться установка Дополнений для гостевой ОС (VirtualBox Guest Additions). Подробнее об установке системы в виртуальную машину, и об установке дополнений можно будет прочитать здесь.

В случае необходимости, вы можете изменить настройки для конкретной виртуальной машины на другие. Для каждой виртуальной машины все настройки индивидуальны.

Далее можно будет приступить к установке операционной системе на виртуальную машину VirtualBox.

Удаление виртуальной машины в VirtualBox

Для удаления виртуальной машины, в главном окне Виртуал Бокс нужно будет войти в меню «Машина», а потом выбрать пункт контекстного меню «Удалить».

Далее откроется окно с вопросом. Вы можете удалить все файлы виртуальной машины, или убрать виртуальную машину из списка виртуальных машин в VirtualBox.

После удаления, все файлы и данные виртуальной машины будут удалены с вашего компьютера.

Заключение

В бесплатной программе VirtualBox можно будет создать новую, или подключить готовую виртуальную машину, применить необходимые настройки для более удобного использования виртуальной машины.

Источник

Источник: https://pomogaemkompu.temaretik.com/1086808046439500623/sozdanie-i-nastrojka-virtualnoj-mashiny-v-virtualbox/

Добавление общих дисков к виртуальным машинам Vmware vSphere

Несмотря на высокую надежность работы виртуальной инфраструктуры Vmware vSphere, необходимо создать сервисы высокой доступности (обновление ПО или ОС, связанные с перезагрузкой либо сервиса, либо сервера целиком). Например кластерный файловый сервер. В данном случае кластеру серверов необходимо предоставить устройство, на котором будет располагаться общая файловая система.

В данной статье будет рассмотрен вариант подключения к виртуальным машинам одного диска, выделенного на отдельно стоящей дисковой полке и предоставленного всем хостам ESXi в кластере Vmware vSphere.

Будем считать, что мы уже установили два виртуальных сервера. Прежде чем их настраивать в кластер, необходимо предоставить какой-то общий диск.

Добавление общего диска к первой ВМ кластера

- Выключаем виртуальную машину.

- В списке виртуальных машин выбираем ту, с которой предстоит работать и открываем окно свойств

- Для того, что бы добавить общий диск, необходимо сначала добавить новый SCSI контроллер.

Раскрываем список “New device”, выбираем “SCSI Controller”, жмем “Add” и переходим к настройке вновь добавленного контроллера.

- Параметры нового контроллера:

Уточнения по параметрам:

Устанавливаем тип контроллера: LSI Logic SASSCSI Bus Sharing выбираем в зависимости от того где будет работать кластер виртуальных машин:Virtual – виртуальный диск, совместно используемый ВМ в пределах одного хоста ESXi

Physical – файл vmdk может использоваться совместно с ВМ на разных ESXi хостах.

У нас чуть больше чем один хост ESXi и виртуальные машины должны распологаться на разных хостах. Поэтому выбираем тип Physical - Жмем “Ok”

- Теперь нам на этой ВМ необходимо добавить новый диск, предоставленный дисковым хранилищем. Опять открываем свойства ВМ и в выпадающем списке добавления нового оборудования выбираем “RDM Disk”. Нажимаем “Add” и в открывшемся окне выбираем необходимый нам диск.

- Устанавливаем параметры диска:

VM storage policy – оставляем без изменений

Location – устанавливаем общее хранилище, где будет храниться ссылка на диск

Sharing – устанавливаем Multi-writer

Virtual Device Node – выбираем ранее добавленный SCSI контроллер

Далее переходим к настройкам второй ВМ.

Добавление общего диска к второй ВМ кластера

- Так же как и на первой ВМ добавляем новый SCSI контроллер.

- Затем добавляем новый диск.

В выпадающем списке выбираем “Existing Hard Disk”

- Нажимаем “Add” и выбираем ранее созданный диск:

- Жмем “Ok” и переходим к настройкам добавленного диска:

Устанавливаем Sharing в Multi-writer

Устанавливаем Disk Mode в Independent – Persistdend. В этом режиме диск не будет участвовать в процессе снимков виртуальной машины.

Virtual Device Node – устанавливаем ранее добавленный SCSI контроллер. - Жмем “Ok”

Если требуется использовать более одного общего диска в VMware, то для каждого из них не требуется дополнительный контроллер SCSI. Один контроллер может обслуживать до 16 различных дисков.

Небольшое, но очень важное уточнение. При использовании SCSI контроллера в режиме “SCSI bus Sharing” не возможно использовать моментальные снимки (snapshot) виртуальных машин. Так же становится невозможной миграция ВМ между хостами. Это необходимо учитывать при планировании кластерной структуры серверов в среде Vmware vSphere.

На этом настройка аппаратной части виртуальных машин завершена. Включаем обе виртуальные машины и приступаем к настройке кластера уже на уровне операционной системы. В следующей статье речь пойдет о создании файлового сервера NFS в кластере высокой доступности.

Прочитано 1434 раз Последнее изменение Понедельник, 19 февраля 2018 12:14

Источник: https://www.arus.ru/index.php/biblioteka/item/10570-dobavlenie-obshchikh-diskov-k-virtualnym-mashinam-vmware-vsphere

KVM – KVM + disk IO

OS: Debian Linux Squeeze 6.0.4 (amd64).Application: KVM 0.12.5 (Kernel-based Virtual Machine).Задача: выбор типа виртуального диска KVM и параметров конфигурации, создающих наименьшее сопротивление трафику ввода/вывода.

Методика:Выбор типа носителя виртуального диска;Выбор типа разметки носителя виртуального диска;Разметка раздела, выделенного под тесты, форматирование его, если в этом есть необходимость;Выбор типа виртуального диска;Выбор типа разметки виртуального диска;Установка на виртуальный диск операционной системы (Debian Linux Squeeze 6.0.

4 (amd64)) по условному сценарию, одинаковому для всех тестов;Загрузка на диск массива файлов (архив справочных пособий и дистрибутивов, общим объёмом около 5-ти Гигабайт (5 337 369 897 байт, 7489 файла в составе 429-ти директорий)), неизменный на период тестов;Перед запуском теста сброс дискового “кеша” операционной системы;

Перемещение заготовленного массива файлов в бинарный архив без сжатия с последующей распаковкой такового, что позволит избежать побочных эффектов от перегрузки процессора (синтетические тесты проводить не вижу смысла).

Да, методика небыстрая, много работы с установкой системы перед каждой серией тестов, но мне хотелось по возможности воссоздать реальные условия эксплуатации.

Варианты тестов:disk partition + KVM cache writethrough (default);disk partition + KVM cache writeback;disk partition + KVM cache none;XFS + raw + no preallocation + KVM cache writethrough (default);XFS + raw + no preallocation + KVM cache writeback;XFS + raw + no preallocation + KVM cache none;XFS + raw + preallocation + KVM cache writethrough (default);XFS + raw + preallocation + KVM cache writeback;XFS + raw + preallocation + KVM cache none;XFS + QCOW2 + no preallocation + KVM cache writethrough (default);XFS + QCOW2 + no preallocation + KVM cache writeback;XFS + QCOW2 + no preallocation + KVM cache none;XFS + QCOW2 + preallocation + KVM cache writethrough (default);XFS + QCOW2 + preallocation + KVM cache writeback;

XFS + QCOW2 + preallocation + KVM cache none;

Прежде чем заниматься непосредственно тестированием, подготовим операционную систему носитель к обеспечению достаточно неизменной производительности; в частности, с помощью “cpufrequtils” устанавливаем для всех ядер центрального процессора режим выдачи максимальной частоты (по умолчанию выбран режим адаптивной подстройки частоты центрального процессора в зависимости от нагрузки, вносящий существенные погрешности в результаты любых тестов).# aptitude install cpufrequtils# lsmod | grep acpi_cpufreq# modprobe acpi-cpufreq

# cpufreq-info

….analyzing CPU 0:…. available frequency steps: 2.70 GHz, 1.80 GHz, 1.20 GHz current policy: frequency should be within 1.20 GHz and 2.70 GHz. The governor “ondemand” may decide which speed to use within this range.

….

Видно, что ядра процессора готовы переключатся между частотой в 1.20 GHz и 2.70 GHz, шагами по 2.7 GHz, 1.8 GHz и 1.2 GHz. По умолчанию выбрана схема “подачи частоты” по необходимости, что меня не устраивает. Профиль “cpufreq” в Debian Squeeze меняется прямо в скрипте инициализации:

# cat /etc/init.d/cpufrequtils

….ENABLE=”true”GOVERNOR=”performance”

….

# /etc/init.d/cpufrequtils restart

Заранее, не тратя время на автоматизацию процесса, вручную создаём тестовый виртуальный сетевой интерфейс и подключаем его к виртуальному системному “мосту” (можно этого и не делать, обходясь поддержкой встроенного в KVM NAT, но мне хотелось простого прямого доступа к тестируемым машинам):# tunctl -b -t tap0# ifconfig tap0 0.0.0.0 up

# brctl addif br0 tap0

Теперь пишем скрипт, с помощью которого будем формировать строку запуска виртуальной машины:

# touch ~/start-vm.sh

# chmod ugo+rx ~/start-vm.sh

#!/bin/bashexport PATH=/sbin:/bin:/usr/sbin:/usr/bin:/usr/local/sbin:/usr/local/binDATE=`date +”%Y-%m-%d %H:%M:%S”`# Disk: address disk partition, RAW file or QCOW2 fileDSK0=””# Cache: “writethrough” (default), “writeback” or “none”CACHE=””# “c” – HDD or “d” – CDBOOTORDER=””DRIVE0=”-drive file=${DSK0},if=ide,index=1,media=disk,snapshot=off,cache=${CACHE},aio=threads”CD0=”-drive file=/path/to/image.iso,if=ide,index=2,media=cdrom”/usr/bin/kvm -name test -daemonize -enable-kvm ${DRIVE0} ${CD0} -boot ${BOOTORDER} -m 256 -cpu host -smp 1,cores=1 -clock unix -rtc base=utc,clock=vm -no-hpet -vnc :1 -net nic,macaddr=52:54:0c:b8:71:b0,model=rtl8139 -net tap,ifname=tap0,script=no,downscript=no# VNC: 5901

exit 0

Вначале мы запускаем скрипт для установки системы в виртуальную машину, применяя к переменной “BOOTORDER” значение “d”, потом запускаем уже установленную систему со значением переменной – “c”.В моём случае дисковый контроллер “virtio” нестабильно себя вёл, запросто мог “увидеть” диск при одном запуске и “не увидеть” его-же при следующем.

Пришлось от него отказаться в пользу привычного IDE, в конце-концов тесты на сравнительные, а не абсолютные показатели.В соответствии с планом пришлось несколько раз устанавливать тестовые операционные системы на вновь создаваемые виртуальные диски.

Сценарий установки был неизменен и таков:Advansed options;Expert install;Choose language => English, Location => US, Locale => en_US.UTF-8, Select a keyboard layout => PC-style, Keymap => American English;Load installer componets from CD => cfdisk-udeb, parted-udeb;Configure the network => IP manual, Hostname => debian.

local;Set users and passwords => Enable shadow, enable login as root, one new user;Configure the clock => No using NTP, UTC;Partition disks => msdos type; 100 GB ATA QEMU HARDDISK, primary, / as Ext3, noatime, bootable; 1.1 GB primary, swap;Install the base system => linux-image-2.6.32.

5-amd64, generic drivers;Configure the package manager => no network mirror;Select and install software => SSH server, Standard system utilites;Install the GRUB boot loader => to the master boot record;

Finish.

После инсталляции тестовой операционной системы на неё загружалась масса файлов, время дальнейшей обработки которых и давало возможность оценить производительность дисковой подсистемы. На стороне тестовой системы создавался скрипт, запускающий на исполнение тесты с фиксированием времени, затраченного на исполнение:

# touch ~/start-test.sh

# chmod ugo+rx ~/start-test.sh

#!/bin/bashexport PATH=/sbin:/bin:/usr/sbin:/usr/bin:/usr/local/sbin:/usr/local/bin# DATE=`date +”%Y-%m-%d %H:%M:%S”`DIRHOME=”~”DIRFROM=”${DIRHOME}/from”DIRTO=”${DIRHOME}/to”echo “tar-step-1-pack-begin: `date +”%Y-%m-%d %H:%M:%S”`” >> ${DIRHOME}/test.logtar -cf ${DIRTO}/step-1.tar ${DIRFROM}echo “tar-step-1-pack-end: `date +”%Y-%m-%d %H:%M:%S”`” >> ${DIRHOME}/test.logecho “tar-step-2-pack-begin: `date +”%Y-%m-%d %H:%M:%S”`” >> ${DIRHOME}/test.logtar -cf ${DIRTO}/step-2.tar ${DIRFROM}echo “tar-step-2-pack-end: `date +”%Y-%m-%d %H:%M:%S”`” >> ${DIRHOME}/test.logcd ${DIRTO}echo “tar-step-3-unpack-begin: `date +”%Y-%m-%d %H:%M:%S”`” >> ${DIRHOME}/test.logtar -xf ${DIRTO}/step-1.tartar -xf ${DIRTO}/step-2.tarecho “tar-step-3-unpack-end: `date +”%Y-%m-%d %H:%M:%S”`” >> ${DIRHOME}/test.logrm -r ${DIRTO}/*

exit 0

Непосредственно перед каждым запуском теста в тестовой виртуальной машине операционной системе носителя отдавалось указание принудительно записать содержимое “кеша” дисковой подсистемы на физические носители с помощью соответствующей команды:

# sync

Так-же, после каждого теста на упаковку и распаковку массы файлов вручную запускались, последовательно, тесты на скорость записи/чтения в файловую систему с помощью утилит dd и hdparm, что давало возможность подтвердить тренды основных тестов с помощью утилиты “tar”:Вначале в обычном режиме:

# dd if=/dev/zero of=/tmp/test bs=1M count=1024

Потом, по возможности минуя дисковые “кеши”, с использованием “прямого доступа”:

# dd if=/dev/zero of=/tmp/test bs=1M count=1024 oflag=direct

Напоследок – тест чтения:

# hdparm -Tt /dev/sda

Далее – более детально о подготовке виртуальных дисков.В первой серии тестов использовался раздел диска (он-же – LVM-раздел). С этим всё просто – указываем KVM на него, как на виртуальный диск, не настраивая ничего.

Все дальнейшие тесты проводились на файловой системе XFS (Silicon Graphics FS), под которую был отформатирован тот-же раздел. Почему XFS? А вот нравится она мне.

Перед форматированием зачищалась начальная область используемого блочного устройства, чтобы затереть всё, что может быть воспринято как “мета”-данные, на всякий случай:

# dd if=/dev/zero of=/dev/sdaX bs=1k count=1000

Создаем файловую систему XFS:

# aptitude install xfsprogs

# mkfs.xfs -d agcount=64 -l size=32m -b size=4k /dev/sdaX

Где:”-d agcount” (allocation groups) – параметр, влияющий на эффективность параллельной записи на устройство. В соответствии с рекомендациями разработчиков на каждые 4 (четыре) Гигабайта на блочном устройстве желательно иметь одну “allocation groups” (250/4~64).

Если пропустить назначение этого параметра, драйвер сам будет его определять и, все хором говорят, это не лучшим образом скажется на производительности;”-l size” – параметр, определяющий размер журнала для “метаданных”.

Внятных рекомендаций я не нашёл, но подумал, что для 250GB диска вполне должно хватить и 32 (тридцати двух) Мегабайт;

“-b size” – параметр, определяющий размер блока (кластера в терминологии Windows), на которые делится дисковый раздел (грубая логика: большие файлы – большие блоки, маленькие файлы – маленькие блоки) (по умолчанию: 4KB; В XFS для Linux задать размер блока более 4KB невозможно, а жаль).

Файловая система монтировалась следующим образом, вручную:

# mkdir -p /mnt/storage

# mount -t xfs -o rw,noatime,nodiratime,nodev,nosuid,noexec /dev/sdaX /mnt/storage

Пару раз, в качестве развлечения, файловая система монтировалась в режиме “синхронной” записи:

# mount -t xfs -o rw,noatime,nodiratime,nodev,nosuid,noexec,sync /dev/sdaX /mnt/storage

Естественно, результатом было снижение скорости записи, просто неприемлемое для практической работы системы виртуализации.По подготовке файлов дисков виртуальных машин – далее.

Если обеспечение компактности виртуального диска стоит прежде обеспечения максимальной производительности дисковой подсистемы, то RAW-диск можно создать с помощью утилиты “kvm-img”:

# kvm-img create -f raw /mnt/storage/test-vm.raw 100G

Следует иметь в виду, что для реальной производственной эксплуатации RAW-диск лучше создавать не с помощью утилиты “kvm-img”, которая лишь расставляет точки “мета”-данных, а заполнить всё выделенное для файла виртуального диска пространство “нулями” с помощью утилиты “dd”, заранее подготавливая всё виртуальное дисковое пространство к немедленному использованию:

# dd if=/dev/zero of=/mnt/storage/test-vm.raw bs=1G count=100

Это долго, да, но оно того стоит (заранее полностью подготовленный утилитой “dd” диск демонстрирует скорость доступа на 10-15% большую, нежели для диска, лишь размеченного для последующего заполнения данными утилитой “kvm-img”):

107374182400 bytes (107 GB) copied, 1437.66 s, 74.7 MB/s

Подход при подготовке виртуального диска формата QCOW2 (QEMU Copy-On-Write), предлагаемого разработчиками KVM, схож с методом подготовки RAW-дисков.

Можно создать диск путём объявления наличия файла объёма, ограниченного определённым значением, начальный (для стороннего наблюдателя) размер которого будет минимален (режим по умолчанию):

# kvm-img create -f qcow2 /mnt/storage/test-vm.qcow2 100G

Виртуальный диск при этом создаётся за доли секунды, размер исходного файла крошечный, около 200KB.Лучше создавать виртуальный диск QCOW2 с разметкой его “мета”-данными (размеченный “мета”-данными диск демонстрирует скорость доступа на 5-7% большую, нежели диск, не размеченный таким образом):

# kvm-img create -f qcow2 -o preallocation=metadata /mnt/storage/test-vm.qcow2 100G

Файл при этом создаётся соответствующего размера, в нашем случае – 100 Гигабайт.На этом об обстоятельствах – всё.Работа проводилась с полным соблюдением заявленных выше условий; ушло на это почти три рабочих дня. Каждый тест прогонялся по два раза, после выводилось среднее арифметическое. Все результаты подтверждались контрольными тестами с помощью утилит “dd” и “hdparm”.

Была мысль выложить “полотенце” таблицы с результатами, но решил ограничится графиками вариантов конфигурации, позволяющих достигнуть максимальной производительности дисковой подсистемы.Вариант первый, с использованием в качестве виртуального дискового устройства реального дискового или LVM раздела:размер: 320 400 640 800 1024 1280

Performance of the KVM disk subsystem.

Partition variant.

Видно, что пиковая производительность достигается с использованием “кеша” типа “writethrough” (что предусмотрено по умолчанию). Я бы рекомендовал отключать виртуальный “кеш” вообще – стабильнее показатели скорости записи и чтения.Вариант второй, с использованием RAW-файла, размещённого на файловой системе XFS:

Performance of the KVM disk subsystem. XFS + RAW + preallocation variant.

Видно, что пиковая производительность достигается с использованием “кеша” типа “writeback” (“кеш” файловой системы помогает).

Забавно, но использование “кеша” типа “writethrough” (включаемого по умолчанию) демонстрирует просто провальные показатели скорости дисковой подсистемы (привет всем, кто пробовал KVM и разочаровался в нём по причине крайне медленной работы).

Если физический дисковый контроллер достаточно серьёзный, с кешем на аккумуляторах, то из RAW-файла можно выжимать максимум, используя виртуальное “кеширование” с алгоритмом “writeback”; в противном случае рекомендую отключить вообще виртуальный “кеш”, для пущей сохранности данных (вдруг системный блок отключится более неожиданно, чем обычно).Вариант третий, с использованием QCOW2-файла, размещённого на файловой системе XFS:

Performance of the KVM disk subsystem. XFS + QCOW2 + preallocation variant.

Видно, что картина в общем повторяет вариант с XFS+RAW, только показатели ниже на 20-25%. Ну, что-же – формат удобный более для лабораторных условий, когда виртуальными машинами нужно постоянно вертеть-крутить, нежели для эксплуатации в производственных условиях, требующих максимальной отдачи в неизменном окружении.

Естественно, что усреднённая скорость обработки массива файлов разного размера существенно ниже пиковых возможностей потоковой записи виртуального или физического дискового устройства.

В частности, максимальные достигнутые усреднённые значения скорости записи утилитой “tar” на виртуальный диск не превысили 30 (тридцати) Мегабайт в секунду, в то время как утилита “dd” демонстрировала скорость небуферизированой записи в 78 (семьдесят восемь) Мегабайт в секунду.

Источник: http://www.umgum.com/kvm-performance-disk-subsystem

Записки программиста

Мне лично проще всего думать о KVM (Kernel-based Virtual Machine), как о таком уровне абстракции над технологиями хардверной виртуализации Intel VT-x и AMD-V.

Берем машину с процессором, поддерживающим одну из этих технологий, ставим на эту машину Linux, в Linux’е устанавливаем KVM, в результате получаем возможность создавать виртуалки. Так примерно и работают облачные хостинги, например, Amazon Web Services.

Наряду с KVM иногда также используется и Xen, но обсуждение этой технологии уже выходит за рамки данного поста. В отличие от технологий контейнерной виртуализации, например, того же Docker, KVM позволяет запускать в качестве гостевой системы любую ОС, но при этом имеет и большие накладные расходы на виртуализацию.

<\p>

Примечание: Описанные ниже действия были проверены мной на Ubuntu Linux 14.04, но по идее будут во многом справедливы как для других версий Ubuntu, так и других дистрибутивов Linux. Все должно работать как на десктопе, так и на сервере, доступ к которому осуществляется по SSH.

Установка KVM

Проверяем, поддерживается ли Intel VT-x или AMD-V нашим процессором:

grep -E '(vmx|svm)' /proc/cpuinfo

Если что-то нагреполось, значит поддерживается, и можно действовать дальше.

Устанавливаем KVM:

sudo apt-get update

sudo apt-get install qemu-kvm libvirt-bin virtinst bridge-utils

Что где принято хранить:

- /var/lib/libvirt/boot/ — ISO-образы для установки гостевых систем;

- /var/lib/libvirt/images/ — образы жестких дисков гостевых систем;

- /var/log/libvirt/ — тут следует искать все логи;

- /etc/libvirt/ — каталог с файлами конфигурации;

Теперь, когда KVM установлен, создадим нашу первую виртуалку.

Создание первой виртуалки

В качестве гостевой системы я выбрал FreeBSD. Качаем ISO-образ системы:

cd /var/lib/libvirt/boot/

sudo wget http://ftp.freebsd.org/path/to/some-freebsd-disk.iso

Управление виртуальными машинами в большинстве случаев производится при помощи утилиты virsh:

Перед запуском виртуалки нам понадобится собрать кое-какие дополнительные сведения.

Смотрим список доступных сетей:

Просмотр информации о конкретной сети (с именем default):

sudo virsh net-info default

Смотрим список доступных оптимизаций для гостевых ОС:

sudo virt-install –os-variant list

Итак, теперь создаем виртуальную машину с 1 CPU, 1 Гб RAM и 32 Гб места на диске, подключенную к сети default:

sudo virt-install

–virt-type=kvm

–name freebsd10

–ram 1024

–vcpus=1

–os-variant=freebsd8

–hvm

–cdrom=/var/lib/libvirt/boot/FreeBSD-10.2-RELEASE-amd64-disc1.iso

–network network=default,model=virtio

–graphics vnc

–disk path=/var/lib/libvirt/images/freebsd10.img,size=32,bus=virtio

Вы можете увидеть:

WARNING Unable to connect to graphical console: virt-viewer not installed. Please install the 'virt-viewer' package. Domain installation still in progress. You can reconnect to the console

to complete the installation process.

Это нормально, так и должно быть.

Затем смотрим свойства виртуалки в формате XML:

sudo virsh dumpxml freebsd10

Тут приводится наиболее полная информация. В том числе есть, к примеру, и MAC-адрес, который понадобятся нам далее. Пока что находим информацию о VNC. В моем случае:

С помощью любимого клиента (я лично пользуюсь Rammina) заходим по VNC, при необходимости используя SSH port forwarding. Попадаем прямо в инстялятор FreeBSD. Дальше все как обычно — Next, Next, Next, получаем установленную систему.

Основные команды

Давайте теперь рассмотрим основные команды для работы с KVM.

Получение списка всех виртуалок:

Получение информации о конкретной виртуалке:

sudo virsh dominfo freebsd10

Запустить виртуалку:

sudo virsh start freebsd10

Остановить виртуалку:

sudo virsh shutdown freebsd10

Жестко прибить виртуалку (несмотря на название, это не удаление):

sudo virsh destroy freebsd10

Ребутнуть виртуалку:

sudo virsh reboot freebsd10

Склонировать виртуалку:

sudo virt-clone -o freebsd10 -n freebsd10-clone

–file /var/lib/libvirt/images/freebsd10-clone.img

Включить/выключить автозапуск:

sudo virsh autostart freebsd10

sudo virsh autostart –disable freebsd10

Запуск virsh в диалоговом режиме (все команды в диалоговом режиме — как описано выше):

Редактирование свойств виртуалки в XML, в том числе здесь можно изменить ограничение на количество памяти и тд:

sudo virsh edit freebsd10

Важно!

Источник: https://eax.me/kvm/

Создание виртуальной машины kvm из консоли

Оглавление:

Создание хранилища.

Создание виртуальной машины kvm, с помощью virt-install.

Создание хранилища

Для начала создадим хранилище виртуальных машин.

Я буду использовать простой тип хранилища, основанный на папках.

Создадим папку

mkdir /home/goodigy/kvm

Создадим хранилище

sudo virsh pool-define-as storage dir – – – – “/home/goodigy/kvm”

storage – название хранилища,

dir – – – – “/home/goodigy/kvm” – путь к папке.

Проверяем

sudo virsh pool-list –all

Вывод должен быть таким

Имя Статус Автозапуск

—————————————————-

storage не активен нет

Собираем хранилище

sudo virsh pool-build storage

Запускаем хранилище

sudo virsh pool-start storage

Добавляем в автозагрузку

sudo virsh pool-autostart storage

Проверяем

sudo virsh pool-list —all

Имя Статус Автозапуск

—————————————————-

storage активен да

Информация о хранилище

sudo virsh pool-info storage

Создание виртуальной машины kvm, с помощью virt-install

Устанавливать мы будем с помощью утилиты virt-install

sudo apt-get install virt-install

Создание виртуальной машины, например, с опреционной системой CentOs на борту.

virt-install

-n CentOs

-r 1024

–vcpus=2

-c /home/goodigy/dists/CentOs-7.0-1406-x86_64-Minimal.iso

–disk pool=storage,size=20,bus=virtio,format=qcow2,cache=writeback

–graphics vnc,listen=0.0.0.0

- -n – название нашей машины, CentOs;

- -r – выделяемая память, 1024Мб;

- –vcpus – процессор;

- -c – путь к iso-образу установочного диска;

- –disk – виртуальный hdd;

- pool — название хранилища, storage;

- size — размер hdd, 20Гб;

Можно указать еще очень много параметров.

Узнать какие существуют

virt-install –help

Установка виртуальной машины с существующим диском, на примере виртуальной машины битрикса, описанной в одной из предыдущих статей.

virt-install

-n bitrix

-r 512

–vcpus=1

–os-type=linux

–os-variant=virtio26

–boot hd

–disk “/home/igy/kvm/bitrix2.img”,bus=virtio,format=qcow2,cache=writeback

–graphics vnc,listen=0.0.0.0

- –os-type – linux или windows;

- –os-variant – одно значение из списка, можно посмотреть командой virt-install –os-variant list;

Ссылки:

Создание хранилища.

Virsh.

Virt-install.

Источник: http://goodigy.ru/ustanovka_mashin_virt-install

Использование физического диска в VirtualBox

При использовании системы виртуализации VirtualBox чаще всего используют виртуальные диски. Они дают возможность гибко распределять дисковое пространство и выделять гораздо больше дискового пространства, чем у вас реально есть.

Однако использование физического диска в VirtualBox имеет как минимум одно явное преимущество – это скорость работы.

Кроме того, с реального диска операционную систему при желании можно запускать как в виртуальной машине, так и на реальном железе.

Самое первое, что нужно сделать – это создать раздел на жестком диске, либо подключить еще один жесткий диск, с которым виртуальная машина будет работать.

После этого необходимо создать особенный виртуальный диск, который будет работать с физическим диском.

Создание виртуального диска, указывающего на физический

Вот пример для настоящего физического диска, который будет использоваться в качестве диска виртуальной машины.

В Linux это делается командой:

| VBoxManage internalcommands createrawvmdk -filename drive.vmdk -rawdisk /dev/sdb |

Для выполнения этой команды могут потребоваться права суперпользователя. Таким образом мы получим файл drive.vmdk, который будет указывать на диск /dev/sdb, подключенный к физической машине.

В Windows это будет выглядеть несколько по-другому. Физический диск там указывается несколько по-другому, но смысл будет абсолютно идентичный:

| “C:Program FilesOracleVirtualBoxVBoxManage.exe” internalcommands createrawvmdk -filename C:VMs estvmdrive.vmdk -rawdisk \.PHYSICALDRIVE1 |

Подключение диска к виртуальной машине

Выбираем виртуальную машину, нажимаем Ctrl+S (или кнопку Settings), выбираем “Storage” -> “Controller: SATA”, нажимаем левую кнопку из тех, что расположены ниже.

Выбираем “Add Hard Disk” и в появившемся диалоге выбираем созданный ранее жесткий диск:

И нажимаем “Open”. Предварительно может понадобиться включить текущего пользователя в группу, имеющую доступ к этому устройству на чтение и запись (группа может называться например “disk”). Теперь надо изменить режим доступа. Открываем в меню “File” -> “Virtual Media Manager”. Выбираем наш диск и нажимаем кнопку “Modify”

Выбираем режим доступа “Writethrough”

После этого нажимаем “OK”, затем “Close”. В качестве загрузочного носителя в настройках виртуальной машины можно выбрать жесткий диск.

После этого виртуальную машину можно запускать и устанавливать операционную систему.

Если вы используете логический диск, на котором операционная система уже установлена, то загрузка скорее всего завершится неудачей, поскольку при загрузке не будет найдена таблица разделов.

Источник: https://mnorin.com/ispol-zovanie-fizicheskogo-diska-v-virtualbox.html

Qemu-KVM

system, kernel, virtual

KVM (или Kernel-based Virtual Machine) — это программное решение, обеспечивающее виртуализацию в среде Linux на платформе x86, которая поддерживает аппаратную виртуализацию на базе Intel VT (Virtualization Technology) либо AMD SVM (Secure Virtual Machine).

Проверяем, поддерживает ли CPU аппаратную виртуализацию:

# egrep '(vmx|svm)' /proc/cpuinfo

Если вывод не пустой, значит — процессор поддерживает аппаратную виртуализацию. Кому интересно, все действия выполнялись на конфигурации Intel Xeon Quad Core E3-1230 3.20 GHz / 8GB / 2x 1TB.

Устанавливаем KVM и библиотеки виртуализации:

# apt-get install kvm libvirt

Запускаем сервис KVM

# service libvirtd start

Смотрим, загружен ли модуль KVM

# lsmod | grep kvm

Должны получить вывод:

kvm_intel 52890 16

kvm 314739 1 kvm_intel

В данном случае видим, что загружен модуль kvm_intel, так как произволитель CPU — Intel.

Проверка подключения к KVM

# virsh sysinfo

Должны получить вывод:

HP J01 …..

Просмотрим список физических дисков на хост-сервере:

# fdisk -l

Получился вывод:

Disk /dev/sda: 1000.2 GB, 1000204886016 bytes

……Disk /dev/sdb: 1000.2 GB, 1000204886016 bytes

……

На жестком диске sda установлена ОС, его не трогаем, а вот на sdb создаем раздел на все свободное место диска с файловой системой ext4: (более подробно про следующие операции можно почитать здесь)

Выбираем диск для редактирования

# fdisk /dev/sdb

Создаем новый раздел

Command (m for help): n

Command action e extended p primary partition (1-4)

p

Partition number (1-4): 1

Сохраняем изменения

Command (m for help): w

The partition table has been altered!

Создаем файловую систему ext4 на всем свободном месте диска /dev/sdb

# mkfs.ext4 /dev/sdb1

Создаем точку монтирования нашего жесткого диска для файлов виртуальных машин:

# mkdir /guest_images # chmod 700 /guest_images

# ls -la /guest_images total 8 drwx——. 2 root root 4096 May 28 13:57 . dr-xr-xr-x. 26 root root 4096 May 28 13:57 ..

Многие советуют отключить вообще Selinux, однако мы выберем иной путь. Мы настроим его правильно.

# semanage fcontext -a -t virt_image_t /guest_images

Если выполнение этой команды не будет успешным, надо установить дополнительный пакет. Сначала узнаем, какой пакет предоставляет данную команду

# apt-get install apt-file

# apt-file search /usr/sbin/semanage

Получим вывод:

Устанавливаем policycoreutils-python

# apt-get -y install policycoreutils-python

После этого снова:

# semanage fcontext -a -t virt_image_t /guest_images

Смонтируем раздел /dev/sdb1 в /guest_images

# mount -t ext4 /dev/sdb1 /guest_images

Отредактируем файл /etc/fstab для того, чтобы при перезагрузке хост-сервера раздел с ВМ монтировался автоматически

# vi /etc/fstab

Добавляем строку по примеру тех, что уже имеются в файле

/dev/sdb1 /guest_images ext4 defaults 1 1

Сохраняем файл и продолжаем создание хранилища:

# virsh pool-define-as guest_images_dir dir – – – – “/guest_images” Pool guest_images_dir defined

Проверяем, создалось ли оно:

# virsh pool-list –all Name State Autostart —————————————– default active yes guest_images_dir inactive no

Далее:

# virsh pool-build guest_images_dir Pool guest_images_dir built

Запускаем хранилище:

# virsh pool-start guest_images_dir Pool guest_images_dir started # virsh pool-list –all Name State Autostart —————————————– default active yes guest_images_dir active no

Добавляем в автозагрузку:

# virsh pool-autostart guest_images_dir Pool guest_images_dir marked as autostarted # virsh pool-list –all Name State Autostart —————————————– default active yes guest_images_dir active yes

Проверяем:

# virsh pool-info guest_images_dir

$ virsh attach-disk comp1 /dev/sdb vdd –type disk

$ virsh deatach-disk comp1 vdv$ virsh -c qemu:///system attach-disk comp1 /dev/mapper/vgjb-lvsun–ch sda$ virsh -c qemu:///system attach-device comp1 /root/sunch_disk.xml

https://github.com/retspen/webvirtmgr

# losetup /dev/loop0 foo.img

# kpartx -av /dev/loop0

# mount /dev/mapper/loop0p1 /mnt

# unmount /mnt

# kpartx -dv /dev/loop0

# losetup -d /dev/loop0# modprobe nbd max_part=8

# qemu-nbd –connect=/dev/nbd0 disk.img

# mount /dev/nbd0p1 /mnt

| 2016/12/05 03:08 | vagrant, chef, shell, puppet, salt, ansible, docker, devops, virtual, alpine | |

| 2017/11/09 16:38 | container, virtual | |

| 2017/11/09 16:34 | linux, container, containers, virtual | |

|

2015/10/13 12:01 | virtual |

| 2015/10/13 12:01 | system, kernel, virtual | |

| 2015/10/13 12:01 | vagrant, chef, shell, puppet, salt, ansible, docker, virtual | |

| 2015/10/13 12:01 | virtualbox, virtual | |

|

2018/03/01 01:23 | vagrant, chef, shell, puppet, salt, ansible, docker, virtual |

Источник: http://docs.mirocow.com/doku.php?id=kvm

Как добавить 2-ой жесткий диск в виртуальную машину Windows XP на базе VirtualBox

Виртуализация сегодня получила повсеместное распространение, и это вполне объяснимо. Преимущества технологии неисчерпаемы: экономическая эффективность, надежность, восстанавливаемость, и так далее, и тому подобное. Однако управление виртуальными машинами порой оказывается непростой задачей.

Виртуальные машины могут расширяться до определенного предела, по достижении которого всякое увеличение емкости виртуального жесткого диска становится невозможным. Единственный выход — примонтировать к машине еще один диск.

В VirtualBox такая возможность предусмотрена, хотя процесс налажен не самым удобным образом. Так или иначе, это позволяет значительно расширить виртуальную машину.

Обратите внимание: я буду описывать процесс с использованием виртуальной машины Windows XP в среде VirtualBox, работающей под Linux (Ubuntu 10.10). В других случаях конкретный набор опций может различаться, но принцип действия такой же.

Шаг первый: отключение виртуальной машины

Прежде чем приступать к работе, полностью выключите виртуальную машину, иначе вы не сможете изменять ее настройки.

Шаг второй: создание нового виртуального диска

Создание нового виртуального диска в данном случае осуществляется в два этапа. Сначала нужно создать новую виртуальную машину и в процессе настроить для нее новый виртуальный диск желаемого размера. По умолчанию создается диск емкостью 10 Гбайт.

Если вам этого достаточно, оставьте все как есть, если нет — укажите большее значение.После создания новой виртуальной машины ее можно удалить. Останется новый виртуальный диск, который можно подключить к уже существующей виртуальной машине.

Теперь откройте настройки нужной виртуальной машины и перейдите на вкладку «Носители» (Storage, рис. A), чтобы добавить новый жесткий диск, который затем нужно будет инициализировать в операционной системе.Рисунок A. Как видите, я уже добавил к своей виртуальной машине новый жесткий диск с литерой «D».

Чтобы добавить новый диск, выделите основной контроллер виртуальной машины и нажмите кнопку «Добавить жесткий диск» (Add Hard Disk). После этого в списке носителей появится новый жесткий диск. Выделите его и выберите из выпадающего меню созданный ранее виртуальный диск (рис. B).Рисунок B.

В выпадающем меню «Жесткий диск» (Hard Drive) перечислены все доступные диски.Указав жесткий диск, выберите в выпадающем меню «Слот» (Slot) опцию «Первичный слэйв» (Primary Slave) и нажмите «OK».

Шаг третий: инициализация жесткого диска

После этого запустите виртуальную машину и войдите в систему. Вызовите окно «Выполнить» (Run) из меню «Пуск» (Start) и введите «compmgmt.msc» (без кавычек) в поле «Открыть» (Open).

В открывшемся окне разверните дерево консоли и выберите подраздел «Управление дисками» (Disk Management) в разделе «Запоминающие устройства» (Storage). Выделите новый жесткий диск. Откроется окно мастера инициализации и преобразования дисков (Initialize and Convert Disk Wizard, рис. C).

На втором этапе отметьте нужный диск и нажмите «Далее» (Next).Рисунок C. В списке может оказаться несколько дисков. Выберите нужный.На следующем этапе мастера нужно выбрать диск для преобразования. Отметьте новый жесткий диск и нажмите «Далее». На последнем этапе мастер выведет список предстоящих операций (рис. D).

Рисунок D. Если все верно, нажмите «Готово» (Finish), чтобы инициализировать диск. Страница 1 из 2 | Следующая страница

ДАТА ПУБЛИКАЦИИ МАТЕРИАЛА: 31 янв 2011

Данный материал подготовлен сайтом: www.winblog.ru

Источник: http://hpunix.org/windows-xp/kak-dobavit-vtoroj-zhestkij-disk-v-virtualnuju.html